目次

M-A-PA Comprehensive Survey on Long Context Language Modeling

この論文は、長文コンテキストを処理するための言語モデルに関する包括的な調査を行い、効率的なモデルの取得、トレーニング、評価、そして応用について詳しく述べています。

この論文は、長文脈言語モデル(LCLM)の効率的な訓練と展開に必要なインフラストラクチャの最適化を詳細に探求し、特に長文脈理解や生成における評価手法の新たなパラダイムを提案している点が興味深いです。

論文:https://arxiv.org/abs/2503.17407

リポジトリ:https://github.com/LCLM-Horizon/A-Comprehensive-Survey-For-Long-Context-Language-Modeling

以下は、弊社AI開発ツール「IXV」を用いてこの論文を要約したものです。見出しや章立てが元論文とは異なる場合があります。

概要

長い文脈の効率的な処理は、自然言語処理における持続的な追求であり、長文書、対話、その他のテキストデータの増加に伴い、広範な入力を効果的かつ効率的に処理・分析できる長文脈言語モデル(LCLM)の開発が重要です。本論文では、大規模な言語モデルにおける長文脈モデリングの最近の進展に関する包括的な調査を提示します。

我々の調査は、効果的かつ効率的なLCLMを取得する方法、LCLMを効率的に訓練・展開する方法、LCLMを包括的に評価・分析する方法という3つの主要な側面に基づいて構成されています。最初の側面では、長文脈処理に向けたデータ戦略、アーキテクチャ設計、ワークフローアプローチについて議論します。第二の側面では、LCLMの訓練と推論に必要なインフラストラクチャの詳細な検討を行います。第三の側面では、長文脈理解や長文生成の評価パラダイム、LCLMの行動分析やメカニズムの解釈可能性について提示します。

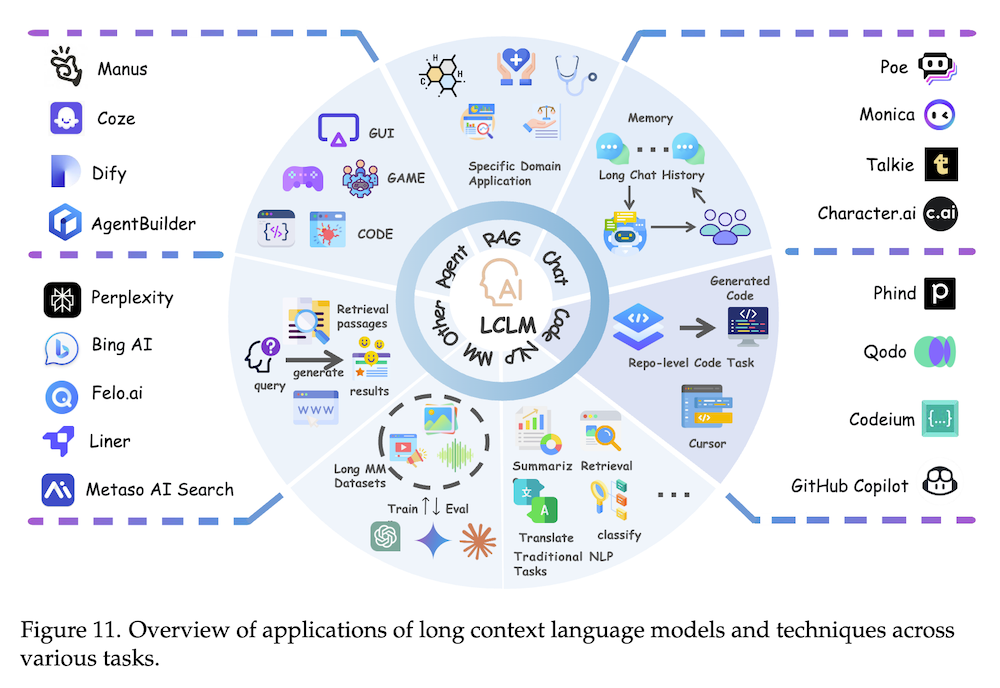

これらの3つの主要な側面を超えて、既存のLCLMが展開されている多様な応用シナリオを徹底的に探求し、有望な今後の開発方向を概説します。この調査は、長文脈LLMに関する文献の最新のレビューを提供し、研究者やエンジニアにとって価値あるリソースとなることを願っています。

論文の要約

1. はじめに

1.1 背景

自然言語処理(NLP)における長文コンテキストの効率的な処理は、持続的な研究課題であり、長文ドキュメントや対話が増加する中、長文コンテキスト言語モデル(LCLMs)の開発がますます重要になっています。本論文では、LCLMsに関連する最近の進展を包括的に調査し、以下の3つの主要な側面に焦点を当てます:

1. LCLMsの取得方法

2. トレーニングと展開の効率化

3. LCLMsの評価と分析方法

2. データ

本章では、LCLMsのためのデータ関連の戦略を扱います。具体的には、トレーニングデータの前処理と後処理に関する手法を説明します。

2.1 トレーニングデータ

2.1.1 データフィルタリング

LCLMsの性能はトレーニングデータの品質に大きく依存します。データの質を向上させるために、短いエントリの除去や重複の排除を行うさまざまな手法が提案されています。特に、長文データに特化した品質評価基準やフィルタリング手法が重要です。

2.1.2 データミクスチャ

トレーニングには多様なソースから取得したデータセットが使用され、データの構成がモデルの性能に影響を与えます。最近の研究では、長文データセットの最適な構成を見つけるためのデータミクスチャの手法が提案されています。

2.1.3 データ合成

リアルワールドでは長文データが希少なため、合成手法が提案されています。これには、関連するテキストをクラスタリングし、文書の冗長性を解消する方法が含まれています。これにより、より豊富なトレーニングデータを生成することができます。

2.2 ポストトレーニングデータ

ポストトレーニングにおいても、データフィルタリングや合成が求められます。特に、長文クエリの効果的な構築を目指し、後処理データのフィルタリング戦略が重要です。影響力のあるサンプルを選び、LCLMsの指示に従う能力を高めます。

3. アーキテクチャ

3.1 ポジション埋め込み

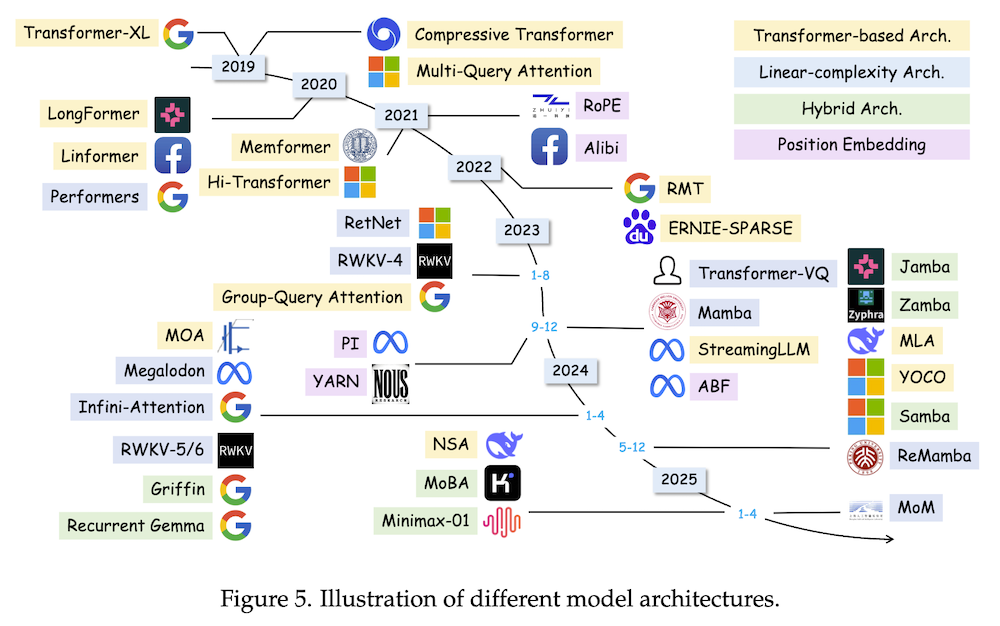

LCLMsはトランスフォーマーアーキテクチャに基づいており、ポジション埋め込みが重要な役割を果たします。ポジション埋め込みには、絶対的、相対的、コンテンツ対応型が存在します。

3.2 注意機構

LCLMsの注意機構には、スパースアテンションや階層的アテンション、リカレントトランスフォーマーなどの技術が含まれます。これらは長文データの処理において、重要な役割を持っています。

結論

本論文は、LCLMsに関する最新の研究を包括的にまとめ、特にデータ処理とアーキテクチャの側面に焦点を当てています。今後の研究では、さらに多様なデータを用いたトレーニングや、モデルの評価手法の改善が求められます。