目次

Exploring the Curious Case of Code Prompts

この論文は、プログラムトレーニングされた言語モデルに対するコードプロンプトとテキストプロンプトの効果を比較し、特定のタスクにおけるパフォーマンスの違いを分析した研究です。

論文:https://arxiv.org/abs/2304.13250

リポジトリ:https://github.com/zharry29/codex_vs_gpt3

以下は、LLMを用いてこの論文の内容を要約したものになります。

要約

この研究では、コードのような表現で言語モデルをプロンプトすることが自然言語タスクのパフォーマンス向上に寄与するかを調査しました。具体的には、質問応答や感情分析、要約などの12のタスクに対して、コードプロンプトとテキストプロンプトの効果を比較しました。結果として、ほとんどのタスクにおいてテキストプロンプトが優れており、コードプロンプトは特定の推論タスクでのみ効果を示しました。また、コードプロンプトのスタイルがパフォーマンスに大きく影響することも確認しましたが、全体としてはテキストプロンプトが依然として最良の方法であることが示されました。今後の研究では、どのタスクがコードプロンプトの恩恵を受けるかを予測する方法を探ることが重要です。

この論文の特徴は、コードプロンプトの効果が特定の推論タスクに限定される一方で、全体としてはテキストプロンプトが依然として優れたパフォーマンスを発揮することを示し、コードプロンプトのスタイルがタスクごとに異なる影響を与えることを明らかにした点です。

以下は、提供された情報を基にした論文の解説記事です。各章ごとに内容をまとめて説明します。

1. コードプロンプトの興味深いケースを探る

1.1 概要

本研究では、自然言語モデル(LM)に対してコードのような構造を持つプロンプトを使用することで、構造的推論タスクにおけるパフォーマンス向上を検討しています。研究の目的は、コードプロンプトが言語モデルとのインタラクションにおいて有用かどうかを明らかにすることです。具体的には、GPTモデル(davinci、code-davinci-002、text-davinci-002)を用いて、質問応答(QA)、感情分析、要約などの多様なタスクにおけるコードプロンプトとテキストプロンプトの性能を比較しています。

2. 実験設計

2.1 モデル選択

本研究では、1750億パラメータを持つオリジナルのdavinciモデルと、テキストとコードの混合で訓練されたcode-davinci-002モデルを使用します。さらに、text-davinci-002も分析対象に含め、テキスト指示に対する解釈能力の影響を調査します。これらのモデルは、監視された指示ファインチューニングを受けていません。

2.2 タスク選択

研究では、質問応答、感情分析、要約などのカテゴリから12のタスクを選定し、特に共通感覚や因果推論タスクに焦点を当てています。これらのタスクは、異なるデータセットからサンプリングされ、評価のために1000例をランダムに選びます。

2.3 プロンプトの定式化

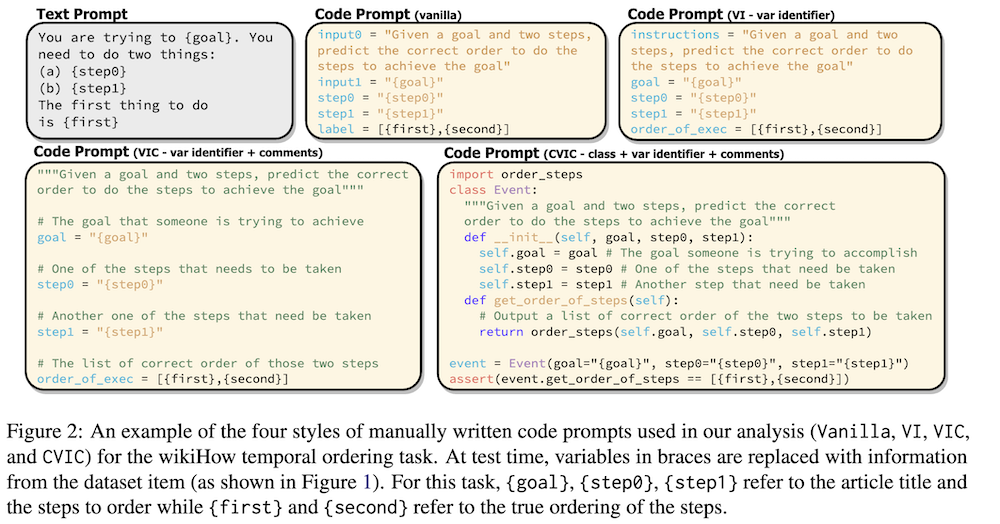

プロンプトはPromptSourceデータセットを使用して収集し、各タスクに対して4種類のカスタムコードプロンプトを手動で作成します。プロンプトのスタイルには、バニラ、変数識別子、変数識別子+コメント、クラス+変数識別子+コメントの4つがあります。

3. 結果

3.1 コードプロンプトの最適なタイプ

4種類のコードプロンプトを比較した結果、特定のタスクにおいて優位なものは見られず、タスクによってパフォーマンスの差異が大きくなることが示されました。特に、変数識別子+コメント(Var Identifier + Comments)スタイルが全体的に良い結果を示しました。

3.2 インコンテキスト例の数

インコンテキスト例の数がモデルの性能に与える影響を調査したところ、ほとんどのタスクで性能への影響が少なく、一部のタスクでは逆効果であることが分かりました。

3.3 コードとテキストプロンプトの比較

12のタスクにおける3つのGPTモデルのパフォーマンスを比較した結果、特定の推論タスクではコードプロンプトがテキストプロンプトよりもパフォーマンスが向上することが確認されましたが、全てのタスクでこの傾向が見られるわけではなく、テキストプロンプトが優れている場合も多いことが示されました。

4. 結論

本研究では、PLMsに対するコードプロンプトとテキストプロンプトの性能差を体系的に調査しました。特定のタスクにおいては、コードプロンプトがテキストプロンプトよりも効果的であることが確認されましたが、ほとんどのタスクではテキストプロンプトが依然として最良の方法であることが示されました。今後の研究では、どのタスクがコードプロンプトから利益を得るかを予測するためのメカニズムを探る必要があります。

付録

A. タスクの詳細説明

各タスクの具体的な説明が付録Aに記載されており、要約、質問応答、共通感覚推論、感情分析などの評価基準やデータセットについて詳細に述べています。

B. コードプロンプトスタイルのランキング

コードプロンプトスタイルの相対的なパフォーマンスを示す表が付録Bに記載されており、どのスタイルが最も効果的であるかが評価されています。

C. アブレーションスタディ

アブレーションスタディの結果が付録Cに示されており、ランダムサンプリングの影響を評価しています。

D. text-davinci-003の評価

新しいtext-davinci-003モデルのパフォーマンスを比較した結果が付録Dに記載されています。

E. 評価コスト

実験にかかるコストの詳細が付録Eに示されています。