目次

Simplifying, Stabilizing & Scaling Continuous-Time Consistency Models

この論文は、連続時間の一貫性モデル(CM)を簡素化、安定化、スケールアップする新しいフレームワークを提案し、従来の生成モデルに比べて高品質な画像を迅速に生成する方法を示しています。

論文:https://arxiv.org/abs/2410.11081

以下は、LLMを用いてこの論文の内容を要約したものになります。

要約

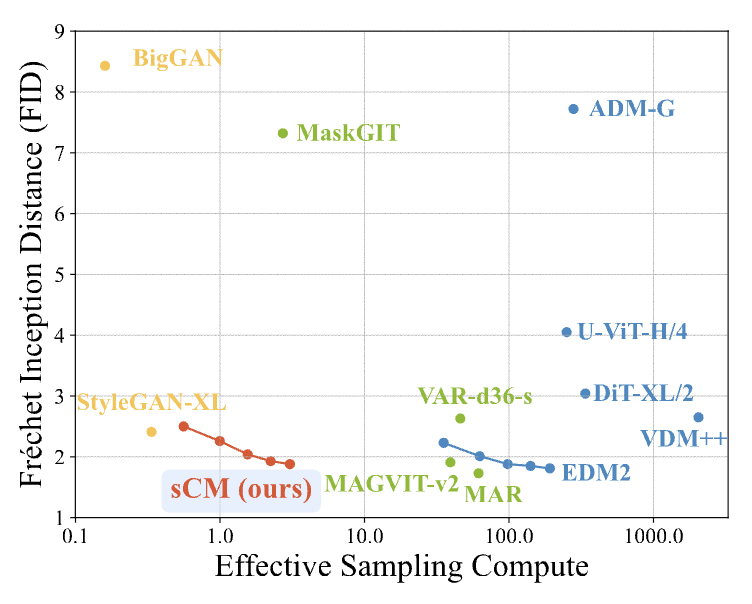

この論文は、連続時間の一貫性モデル(CM)を簡素化、安定化、スケーリングする方法を提案しています。従来のCMは離散化された時刻で訓練されるため、追加のハイパーパラメータと離散化誤差が生じやすいですが、連続時間の定式化はこれらの問題を軽減します。しかし、訓練の不安定性が課題でした。本研究では、従来の拡散モデルのパラメータ化を統一し、訓練の安定性を高めるための重要な改善を導入し、最大1.5億パラメータのCMを訓練しました。提案したアルゴリズムは、少ないサンプリングステップで高いFIDスコアを達成し、最先端の拡散モデルに匹敵する性能を示しました。

論文の解説

1. はじめに

本論文では、連続時間における一貫性モデル(Consistency Models, CMs)の簡素化、安定化、スケーリングに関する新しい理論的枠組み「TrigFlow」を提案しています。従来のCMは離散時間で訓練されるため、追加のハイパーパラメータが必要であり、離散化誤差が生じやすい問題があります。この論文では、連続時間の定式化を採用し、トレーニングの不安定性を克服するためのアプローチを示しています。

2. 前提知識

2.1 拡散モデル

拡散モデルは、データサンプルを徐々にノイズのある状態に変換し、その逆を行うことによってサンプルを生成します。このプロセスでは、ノイズのプロセスを学習し、最終的にクリーンなデータ分布を再現します。

2.2 一貫性モデル

一貫性モデルは、ノイズのある入力から対応するクリーンデータをマッピングすることを目的としたニューラルネットワークです。連続時間のCMは、数値解法に依存せず、より正確な訓練信号を提供しますが、トレーニングの不安定性が問題視されています。

3. 連続時間一貫性モデルの簡素化

3.1 TrigFlowの提案

TrigFlowは、ノイズプロセスを次のように定義します:

\[ x_t = \cos(t)x_0 + \sin(t)z \]

ここで、\( z \)はガウスノイズです。この新しい定式化により、拡散モデルのパラメータ化が簡素化され、トレーニングの安定性が向上します。

4. 連続時間一貫性モデルの安定化

4.1 パラメータ化とネットワークアーキテクチャ

連続時間CMの訓練の安定性を高めるために、時間に基づく正規化や適応型グループ正規化が導入されています。特に、トリグノミック関数を利用した改善が提案されています。

4.2 訓練目的

訓練の目的関数には、接線の正規化や適応重み付けを組み込むことで、トレーニングの不安定性を軽減する手法が含まれています。

5. 連続時間一貫性モデルのスケーリング

5.1 大規模モデルにおける接線計算

大規模モデルの訓練では、計算精度の向上とメモリ効率の良い注意計算が重要です。特に、Flash Attentionを用いることで、接線計算の効率を高める手法が提案されています。

5.2 実験と結果

CIFAR-10やImageNetのデータセットを用いて、提案した手法の効果を評価しました。実験結果において、FIDスコアが従来のモデルに比べて優れた性能を示すことが確認されています。

6. 結論

本研究では、TrigFlowを中心に連続時間一貫性モデルの訓練を簡素化し、安定化させ、スケーリングする新たな手法を提案しました。これにより、訓練の安定性が向上し、サンプリングの品質も改善されました。最終的に、提案手法は従来のモデルに比べてFIDスコアの差を10%以内に縮小することに成功しました。

付録

付録では、提案手法の詳細な数式導出、実験設定、評価結果、訓練アルゴリズムの詳細などが含まれています。