目次

A Survey on the Honesty of Large Language Models

この論文は、大規模言語モデル(LLM)の誠実性に関する調査を行い、誠実性の定義、評価方法、改善戦略を包括的にまとめ、今後の研究の方向性を提案しています。

論文:https://arxiv.org/abs/2409.18786

リポジトリ:https://github.com/SihengLi99/LLM-Honesty-Survey

以下は、LLMを用いてこの論文の内容を要約したものになります。

要約

この論文は、大規模言語モデル(LLMs)の誠実さに関する調査を行っており、誠実さが人間の価値観と調和するための基本的な原則であることを強調しています。著者らは、LLMsが誤った回答を自信満々に提示したり、自らの知識の限界を表現しないなどの不誠実な行動を示すことを指摘し、誠実さの定義の多様性や評価手法の難しさについても論じています。研究の改善策として、自己認識と自己表現の強化を提案し、今後の研究に向けた洞察を提供しています。この調査は、LLMsの誠実さを向上させるための更なる探求を促すことを目的としています。

この論文の特徴は、誠実さの概念を自己認識と自己表現という二つの側面から深く掘り下げ、具体的な評価手法と改善策を提示することで、モデルの誠実さ向上に向けた実践的なアプローチを提供している点です。

論文の解説記事

この論文は、大規模言語モデル(LLM)の誠実性についての包括的な調査を行っています。以下では、各章の内容を具体的にまとめて説明します。

1. はじめに

誠実性はLLMの開発において重要なテーマであり、人間の価値観に沿った基本原則とされています。特に、医療や法律、金融などの高リスク領域では、LLMが誤った情報を自信を持って提供することが大きな問題です。本章では、誠実性の定義や現状の問題点、今後の研究の必要性について述べています。

2. LLMにおける誠実性

2.1 LLMにおける誠実性とは

誠実性は「欺瞞がなく、道徳的に正直であること」と定義され、LLMは正確な情報を提供しつつ、自身の限界を認識しなければなりません。

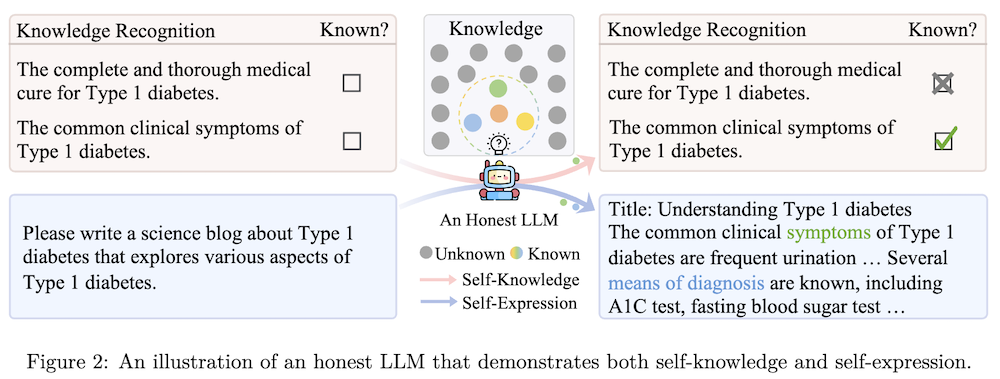

2.2 自己認識

自己認識とは、LLMが自らの知識と無知を認識する能力を意味します。この能力により、モデルは必要な知識が欠けている際に「わからない」と明言でき、誤情報の生成を抑制することが可能です。

2.3 自己表現

自己表現は、LLMが知識を正確に表現する能力を指します。しかし、研究によって、LLMが内部に持つ知識を正確に表現できないことが明らかになっています。

3. LLMの誠実性の評価

3.1 自己認識の評価

自己認識は、知っていることと知らないことを識別する能力で評価されます。二項的判断と信頼度スコアの連続的割り当てが主な方法です。

3.2 自己表現の評価

自己表現の評価は、モデルが知識を正確に表現できるかどうかを測定します。知識の特定に基づくアプローチと、特定なしのアプローチが存在します。

4. 自己認識の改善

4.1 トレーニングなしのアプローチ

予測確率計算やプロンプトを用いることで、自己認識を強化する方法が提案されています。

4.2 トレーニングベースのアプローチ

教師あり微調整や強化学習を用いることで、モデルが「わからない」と表現する能力を向上させることが期待されています。

5. 自己表現の改善

5.1 トレーニングなしのアプローチ

プロンプトを用いてモデルの知識表現能力を強化する手法が提案されています。

5.2 トレーニングベースのアプローチ

自己教師あり微調整や自己監視型微調整を通じて、LLMが生成する情報の正確性と一貫性を向上させることが目指されています。

6. 今後の研究

今後の研究では、LLMの誠実性評価手法の開発や、知識を特定する方法の明確化が求められます。特に、指示に従った長文生成における誠実性の評価や改善方法の探求が期待されています。

7. 結論

誠実性はLLMの開発に不可欠な要素であり、現在のモデルは未だ多くの誠実性の欠如を示しています。この研究は、LLMの誠実性に関する包括的な調査を提供し、今後の研究の方向性を示しています。

この論文は、LLMの誠実性に関する重要な問題を明らかにし、それに対する解決策を探求するための基礎を築くことを目的としています。