目次

A Survey on In-context Learning

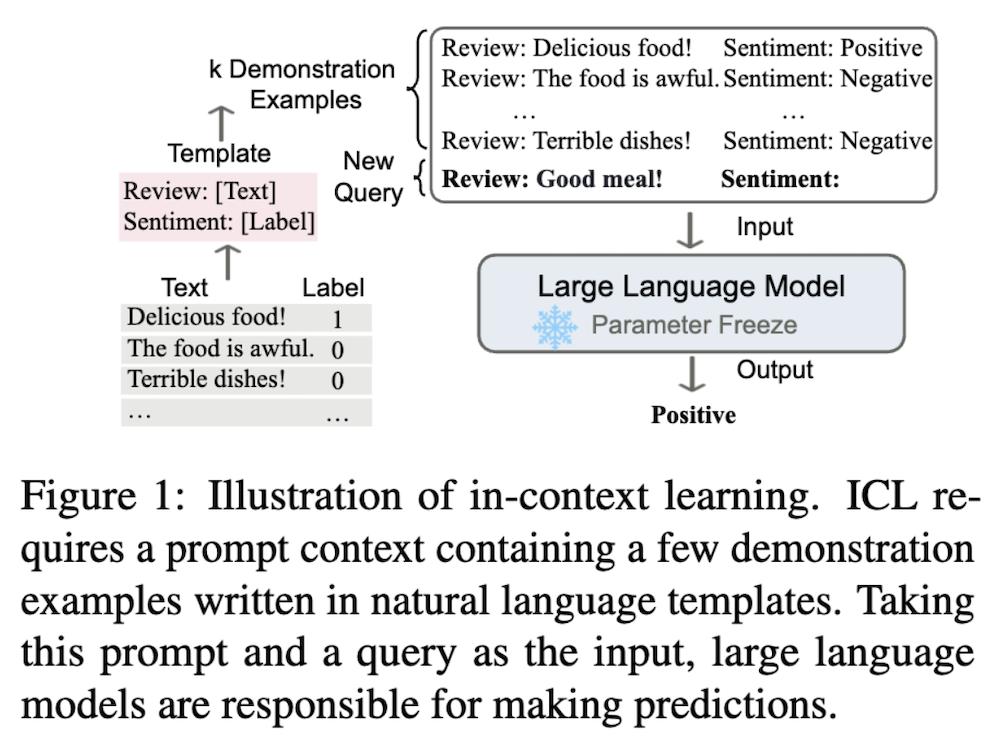

この論文は、大規模言語モデルの新たな能力である文脈内学習(ICL)について包括的にレビューしています。

論文:https://arxiv.org/abs/2301.00234

以下は、LLMを用いてこの論文の内容を要約したものになります。

要約

本論文は、大規模言語モデルの新たな能力である文脈内学習(ICL)について包括的にレビューしています。ICLの定義、関連研究との関係、トレーニング戦略、プロンプト設計、分析手法、そして応用例を詳細に解説しています。また、ICLの課題や将来の研究方向性についても議論しており、ICLのメカニズム解明と性能向上に向けた研究の基礎となることを目指しています。

この論文の特徴は、ICLの様々な側面(トレーニング、プロンプト設計、分析、応用)を体系的に整理し、各テーマにおける最新の手法や知見を詳細に比較・分析している点です。特に、デモンストレーション選択や順序付けなどのプロンプト設計戦略の効果を定量的に評価し、その結果を表にまとめて提示している点が興味深く、実用的な価値が高いです。

文脈内学習(ICL)に関するサーベイ論文の要約

1. はじめに

1.1 ICLの定義と利点

- ICLは、コンテキストに追加された少数の例を基に予測を行うLLMsの新しい能力

- 主な利点:

- 自然言語での解釈可能なインターフェース

- 人間の類推による意思決定プロセスとの類似性

- タスク適応のための計算コストの削減

1.2 ICLの課題と研究の必要性

- 事前学習時の適応によるICL能力の向上可能性

- プロンプトテンプレートや例示の選択・順序などの特定の設定に対する感度

- 例示の簡潔さの最適化とICLの計算効率の向上

- ICLの基本的なメカニズムの解明

2. 定義と定式化

2.1 ICLの形式的定義

- 入力テキスト x と候補回答の集合 Y が与えられたとき

- 事前学習済み言語モデル M は、デモンストレーション集合 C を条件として最大スコアを持つ候補回答を予測

2.2 関連概念との違い

- プロンプト学習:ICLはプロンプトチューニングのサブクラス

- 少数ショット学習:ICLはパラメータ更新を必要としない

3. モデルトレーニング

3.1 事前学習

- 関連するコンテキストを集約して事前学習コーパスを再編成 (Gu et al., 2023; Shi et al., 2024)

- メタ蒸留事前学習プロセスの導入 (Li et al., 2024c)

3.2 ウォームアップ

- 複数のデモンストレーション例を持つ広範なタスクでLLMsを継続的にファインチューニング (Min et al., 2022b; Wang et al., 2022b)

- シンボルチューニング:自然言語ラベルを任意のシンボルに置き換え (Wei et al., 2023a)

- 自己教師あり方法:下流タスクのICLフォーマットと生のテキストを整列 (Chen et al., 2022)

- 指示チューニング:自然言語指示テンプレートを用いてLLMsの指示追従能力を向上 (Wei et al., 2022a; Chung et al., 2022; Wang et al., 2022b)

4. プロンプト設計

4.1 デモンストレーションの構成

4.1.1 デモンストレーションの選択

- 教師なし手法:

- kNN検索 (Liu et al., 2022)

- 相互情報量 (Sorensen et al., 2022)

- パープレキシティ (Gonen et al., 2023)

- LLMsの出力スコアを利用 (Wu et al., 2023b; Li and Qiu, 2023)

- 教師あり手法:

- 2段階の密な検索器トレーニング (Rubin et al., 2022)

- 統一されたデモンストレーション検索器 (Li et al., 2023d)

- デモンストレーションセット全体の検索 (Ye et al., 2023)

- モデル適応型手法 (Mavromatis et al., 2023)

- トピックモデルとしてのLLMs (Wang et al., 2023e)

- 強化学習を用いた例選択 (Zhang et al., 2022a)

4.1.2 デモンストレーションの再フォーマット

- LLMsを用いたデモンストレーションの直接生成 (Kim et al., 2022)

- 特別な位置埋め込みを用いたデモンストレーション例の個別エンコード (Hao et al., 2022b)

- デモンストレーションの潜在表現の修正 (Liu et al., 2024a; Li et al., 2024a)

4.1.3 デモンストレーションの順序付け

- 入力との近さに基づく配置 (Liu et al., 2022)

- グローバルおよびローカルエントロピー指標の利用 (Lu et al., 2022)

- 単純なものから複雑なものへの順序付け (Liu et al., 2024b)

4.2 指示フォーマット

- LLMsによるタスク指示の生成 (Honovich et al., 2023)

- 自動プロンプトエンジニアによる指示生成と選択 (Zhou et al., 2023c)

- LLMsの自己生成を用いた指示の品質向上 (Wang et al., 2023f; Chen et al., 2024)

- チェーン・オブ・ソート (CoT) の導入 (Wei et al., 2022c)

4.3 スコアリング関数

- Direct法:条件付き確率を直接使用

- Perplexity (PPL)法:入力シーケンス全体の文パープレキシティを計算

- Channel法:逆方向の条件付き確率を計算

5. 分析

5.1 影響要因

5.1.1 事前学習段階

- 事前学習コーパスの多様性 (Shin et al., 2022; Yadlowsky et al., 2023; Raventós et al., 2023)

- データ分布の影響 (Chan et al., 2022; Wies et al., 2023)

- モデルアーキテクチャとトレーニングプロセスの影響 (Wei et al., 2022b; Brown et al., 2020; Ding et al., 2024)

5.1.2 推論段階

- 入力ラベル設定 (Min et al., 2022c; Yoo et al., 2022; Pan et al., 2023a; Tang et al., 2023a)

- デモンストレーションの構築 (An et al., 2023; Liu et al., 2022; Lu et al., 2022; Zhang et al., 2022b; Liu et al., 2023b)

- 特徴バイアス (Si et al., 2023)

5.2 学習メカニズム

5.2.1 機能モジュール

- 注意モジュール、特に「誘導ヘッド」の重要性 (Olsson et al., 2022; Bietti et al., 2023; Dai et al., 2023a; Irie et al., 2022; Li et al., 2023c; Gao et al., 2023; Zhang et al., 2023b)

- Transformerの情報フロー分析 (Wang et al., 2023b)

5.2.2 理論的解釈

- ベイズ的観点:ICLを暗黙的なベイズ推論として説明 (Xie et al., 2022; Wies et al., 2023; Ahuja et al., 2023; Jiang, 2023; Wang et al., 2023e)

- 勾配降下観点:Transformer注意とフィードフォワードレイヤーの勾配降下との双対性 (Dai et al., 2023a; von Oswald et al., 2023; Ahn et al., 2023; Mahankali et al., 2023; Li et al., 2023c)

- その他の観点:

- 能力の分解 (Pan et al., 2023b)

- アルゴリズム学習問題としての抽象化 (Akyürek et al., 2023; Garg et al., 2022; Li et al., 2023e; Bai et al., 2023b)

- 情報理論を用いたICLのエラー境界の説明 (Hahn and Goyal, 2023)

6. 応用

6.1 従来のNLPタスクへの応用

- 複雑な推論を必要とするタスクや構成的一般化で顕著な効果 (Wei et al., 2022c; Li et al., 2023b; Zhou et al., 2022; Zhou et al., 2023a)

6.2 新たな応用分野

- データエンジニアリング:高品質なデータを低コストで生成 (Wang et al., 2021; Khorashadizadeh et al., 2023; Ding et al., 2023)

- モデル拡張:

- 検索拡張手法の強化 (Ram et al., 2023)

- より安全な出力へのモデル誘導 (Panda et al., 2023; Meade et al., 2023)

- 知識更新:LLMsの古い知識や誤った知識を修正 (De Cao et al., 2021)

6.3 マルチモーダル応用

- 視覚 (Bar et al., 2022; Wang et al., 2023c)

- 視覚言語 (Tsimpoukelli et al., 2021; Alayrac et al., 2022)

- 音声 (Wang et al., 2023a; Zhang et al., 2023d)

7. 課題と将来の方向性

7.1 効率性とスケーラビリティ

- 計算コストの増加と学習可能なサンプル数の制限が課題

7.2 一般化

- 低資源言語やタスクにおけるICLの一般化能力の課題

- 高資源データを活用した低資源タスクへの対処の可能性

7.3 長文脈ICL

- デモンストレーション数の増加がICLのパフォーマンスに与える影響の研究が必要

8. 結論

ICLに関する既存の文献を包括的にレビューし、高度な技術、分析研究、関連アプリケーションを議論。今後の研究方向性を示唆。