目次

FRAG: Frame Selection Augmented Generation for Long Video and Long Document Understanding

この論文は、長い動画や文書の理解において、関連フレームを選択することで生成を補強する「FRAG」手法を提案し、その性能向上を実証したものです。

FRAGは、長い動画と文書の理解において、従来の大規模マルチモーダルモデルを使用せず、独立したフレームスコアリングによる効率的なフレーム選択を通じて、計算コストを抑えながら性能を大幅に向上させる革新的なアプローチを提案しています。

論文:https://arxiv.org/abs/2504.17447

リポジトリ:https://github.com/NVlabs/FRAG

以下は、弊社AI開発ツール「IXV」を用いてこの論文を要約したものです。見出しや章立てが元論文とは異なる場合があります。

概要

この論文では、大規模マルチモーダルモデル(LMM)の進展を背景に、長い入力(複数ページの文書や長い動画)への適用が探求されています。しかし、これらの長いコンテキストモデルのモデルサイズと性能は、トレーニングと推論にかかる計算コストのために制限されています。本研究では、長いコンテキストのLMMを使用せずに長い入力を処理する別の方向性を探ります。

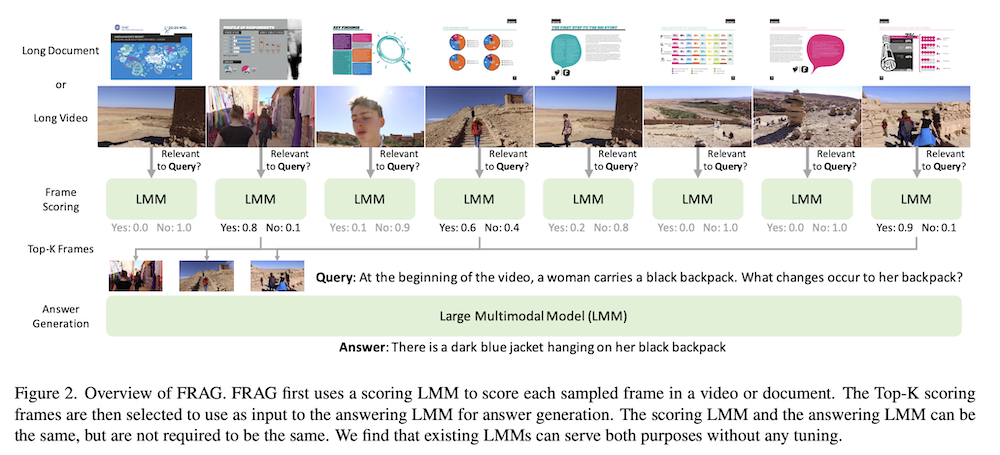

私たちは、FRAG(Frame Selection Augmented Generation)を提案します。この方法では、モデルが最初に入力内の関連フレームを選択し、その後、選択したフレームに基づいて最終的な出力を生成します。選択プロセスの核心は、各フレームを独立にスコア付けすることにあり、長いコンテキスト処理は必要ありません。最高スコアのフレームは、単純なTop-K選択によって選ばれます。私たちは、この非常にシンプルなフレームワークが、長い動画と複数ページの文書の両方に適用可能であることを示し、既存のLMMをファインチューニングなしで利用できます。

実験では、LLaVA-OneVisionとInternVL2の2つのモデルを考慮し、FRAGが性能を一貫して改善し、長い動画と長い文書理解の両方で最先端の性能を達成することを示します。動画に関しては、FRAGはInternVL2-76Bの性能をMLVUで5.8%、Video-MMEで3.7%向上させます。文書に関しては、FRAGは長文書理解に特化した最近のLMMと比較してMP-DocVQAで20%以上の改善を達成します。

要約

この論文では、長いビデオや複数ページの文書を処理するための新しいアプローチ「Frame Selection Augmented Generation (FRAG)」を提案しています。従来の長コンテキストLLMが計算コストや訓練データの制約に直面する中、FRAGは長いコンテキストを処理するLLMを必要としない代替アプローチを提供します。FRAGはまず入力内の関連フレームを選択し、選択されたフレームのみに基づいて最終出力を生成します。選択プロセスの核心は各フレームを独立してスコアリングすることで、長いコンテキスト処理を必要としません。最高スコアのフレームは単純なTop-K選択によって選ばれます。この驚くほどシンプルなフレームワークは、既存のLLMを微調整なしで長いビデオや複数ページの文書に適用できることを示しています。

1. はじめに

大規模マルチモーダルモデル(LMM)は画像や動画のキャプション生成や視覚的質問応答などで印象的な能力を示しています。最近の研究では、これらのモデルを複数ページの文書や長い動画などの長い入力データに拡張しています。しかし、長コンテキストLMMの訓練には、データと計算の両面で課題があります。高品質な長コンテキストデータの入手はより困難で、計算要件も大幅に高くなります。このため、既存の長コンテキストLMMはモデルサイズが制限され、一般的に7Bの範囲に収まっています。

この研究では、「長い入力データに長コンテキストLMMは必要か?」という問いを探ります。例えば、長い動画の中の黒いバックパックに関する質問に答えるには、まず動画を早送りして関連する瞬間(黒いバックパックのあるフレーム)を見つけます。同様に、スライドのパイチャートに関する質問に答えるには、ページをざっと見てパイチャートがあるページに焦点を当てます。これらの例では、長い入力全体が一度に処理されるのではなく、各フレーム/ページが独立して判断されます。

2. 関連研究

長いビデオ理解においては、長コンテキストLMMの登場により多くの評価データセットが出現しました。アプローチとしては、メモリやリサンプラーによる視覚情報の圧縮、またはLMMのコンテキスト長の拡張がありますが、計算負担からモデルサイズが制限されています。複数ページ文書理解では、専門モデルがあるものの、一般的なLMMは単一ページに限られており、高解像度の複数ページ処理には課題があります。フレーム選択に関しては、多くの研究がビデオフレームをテキスト変換して独自言語モデルに依存するか、選択のためのトレーニングを必要としますが、FRAGはゼロショットでどのアプリケーションにも適用可能です。

3. フレーム選択強化生成

FRAGは長いビデオや文書を、まず関連フレーム/ページを選択することで処理します。選択プロセスは(1)各フレームを独立してスコアリングし、(2)最高スコアのフレームを選択して最終出力を生成する、というステップで行われます。スコアリングは独立して行われるため、FRAGは長いビデオや文書を処理するのに長いコンテキストを必要としません。

3.1 独立したフレームスコアリング

長いビデオや文書が与えられると、FRAGの最初のステップは選択提案をスコアリングすることです。これは提案生成と提案スコアリングの2つのステップから構成されます。

提案生成では、まず十分な数のフレーム(例:256)で均一にダウンサンプリングを行い、サンプリングされた各フレームを提案として扱います。より洗練された提案生成方法はありますが、単一フレーム提案方法がTop-K選択と組み合わせて上手く機能することがわかりました。

クエリが与えられると、LMMを使用して各提案をスコアリングします。興味深いことに、LMMはトレーニングなしで高品質なスコアを提供できることがわかりました。スコアリングは、ほとんどのLMMがよくトレーニングされているバイナリ選択問題として定式化されます。

3.2 生成のための選択

次のステップはスコアに基づいて提案を選択することです。単純にTop-Kスコアの提案を選択します。選択されたフレームはビデオの場合は時間順に、文書の場合はページ順にソートされます。最後に、選択されたフレームが回答LMMに入力され、出力を生成します。

単純なTop-K選択はビデオと文書の両方で有効に機能します。ビデオの場合、スコアリングが完璧でなくてもTop-Kを選択することでエラーに対応できます。同様に文書の場合も、質問に答えるために必要な情報のほとんどが1ページに含まれていても、複数のページを選択できます。

4. 実験

4.1 長いビデオ理解の評価

LongVideoBench、MLVU、Video-MME、EgoSchema、NeXT-QAの5つのデータセットを使用しました。LMVUと256フレームからTop-32フレームを選択するFRAG-Top32-256を比較すると、FRAGはすべてのモデルで大幅に結果を改善しました。特に長いビデオ理解のために設計されたLongVideoBenchとMLVUで顕著でした。Video-MMEでも評価したすべてのLMMを改善し、EgoSchemaでも一貫して改善しました。唯一の例外はNeXT-QAで、ビデオの長さが短いため(平均0.8分)、32フレームがすでにビデオの情報のほとんどを捉えています。

4.2 長い文書理解の評価

SlideVQA、MP-DocVQA、MMLongBench-Docの3つのデータセットを考慮しました。文書理解においても、FRAGモデルは均一サンプリングベースラインを大幅に上回りました。高解像度は文書理解に不可欠であり、FRAGはトップ2のページに焦点を当てることで、スライドで最大20%、密度の高い文書のMP-DocVQAでは40%の改善を達成しました。さらに、FRAGの最良のモデル(FRAG-InternVL2-76B)はSlideVQAで28%、MP-DocVQAでは20%の改善を示し、MP-DocVQAリーダーボードで1位を獲得しました。

4.3 アブレーション研究

スコアリングLMMの評価では、スコアリングLMMと回答LMMは同じである必要はないことがわかりました。さまざまなサイズのスコアリングLMMを評価したところ、より大きなモデルはより良いマルチモーダル理解能力を持ち、より良いフレーム選択につながることがわかりました。サンプリングされるフレーム数とTop-K選択で選択されるフレーム数も検証し、それぞれ最適な値を特定しました。

5. 結論

Frame Selection Augmented Generation(FRAG)は、長コンテキストLMMなしで長い入力を処理する方法を提案しています。FRAGはクエリに関連するフレームやページを最初に選択することで、長いビデオと長い文書の理解を大幅に改善します。これはファインチューニングなしでゼロショットで達成でき、単純なTop-K選択のみを使用します。実験により、この統一された最小限のフレームワークが長いビデオと長い文書の理解の両方で最先端の結果を達成することが示されました。将来の研究方向としては、より良い選択戦略とFRAGの効率性の向上が考えられます。