目次

Towards Preventing Overreliance on Task-Oriented Conversational AI Through Accountability Modeling

この論文は、タスク指向会話AIにおける過信を防ぐための説明責任モデルを提案し、ユーザーの過剰依存を軽減する方法を探るものです。

この論文の特徴は、タスク指向対話エージェントにおいて、ユーザーの過剰依存を防ぐために、エージェントのエラーを自動的に修正するアカウンタビリティモデルを導入し、実験によりその有効性を示した点です。

論文:https://arxiv.org/abs/2501.10316

リポジトリ:https://github.com/uiuc-conversational-ai-lab/Accountable-DST

以下は、LLMを用いてこの論文の内容を要約したものになります。

概要

最近の大規模言語モデル(LLM)は、対話エージェントにおいて重要な進展をもたらしました。しかし、これらのモデルはしばしば事実に基づいていないが信頼性があるように見える応答を生成する「幻覚」を起こすことが知られています。一方で、ユーザーはLLMベースのAIエージェントに過剰に依存する傾向があり、誤った提案であってもAIの意見を受け入れてしまいます。AI支援の意思決定システムにおいては、説明やユーザーの確認を求めるなどの「摩擦」を加えることが提案されています。

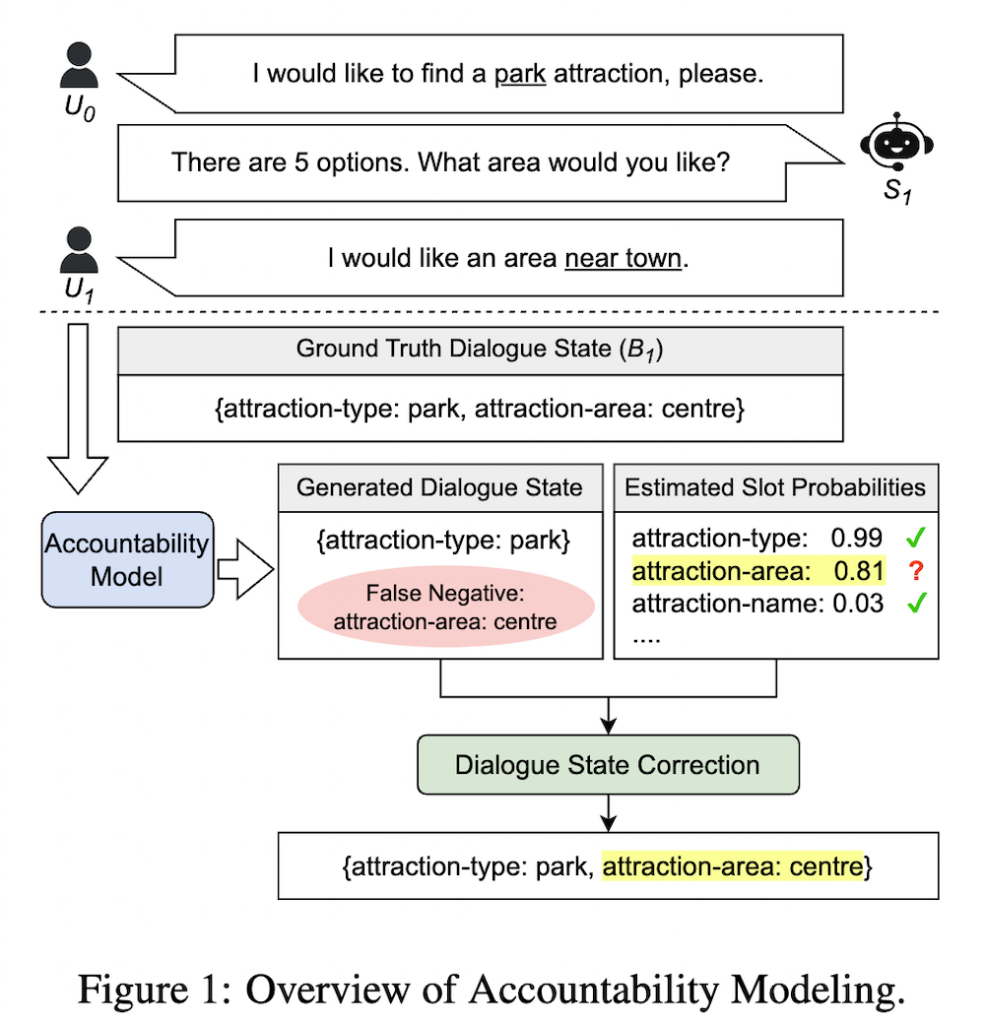

本論文では、対話状態追跡(DST)に関連するモデルの不確実性やエラーに対処するために、LLMベースのタスク指向対話エージェントのためのアカウンタビリティモデルを提案します。アカウンタビリティモデルは、対話状態のスロットを予測するバイナリ分類器として機能する追加のアカウンタビリティヘッドを持つ強化されたLLMです。私たちは、二つの確立されたタスク指向データセット(MultiWOZとSnips)に対して、三つのバックボーンLLM(Llama、Mistral、Gemma)を用いて実験を行いました。実証的な結果は、このアプローチがAIエージェントのエラーの信頼性のある推定を可能にするだけでなく、LLMデコーダーがより正確なアクションを生成するための指針を提供することを示しています。

私たちは、MultiWOZデータセットにおいてアカウンタビリティヘッドを組み込むことで、ジョイントゴールの正確性が約3%改善されることを観察しました。また、この手法がエージェントに自らのアクションを修正させることを可能にし、さらに3%のパフォーマンス向上を実現することを示します。最後に、摩擦を導入することによってユーザーの過剰依存を防ぐためのアカウンタビリティモデルの応用について議論します。

タスク指向会話AIにおける過剰依存防止に向けたアカウンタビリティモデリング

1. 概要

本論文は、タスク指向会話エージェントにおけるユーザーの過剰依存の問題に対処するためのアカウンタビリティモデルを提案しています。最近の大規模言語モデル(LLM)は会話エージェントの進展をもたらしましたが、「ハルシネーション」と呼ばれる現象、すなわち一見信頼できるが事実に基づかない応答を生成する問題が存在します。これにより、ユーザーはAIの提案を誤って受け入れる傾向が強まります。この問題を解決するために、ユーザーに対して説明や確認を促す「フリクション」を導入するアプローチが提案されています。

2. アカウンタビリティモデル

提案されたアカウンタビリティモデルは、既存のLLMに追加のアカウンタビリティヘッドを組み込むもので、ダイアログ状態追跡(DST)に関連するモデルの不確実性やエラーに対処するための二値分類器として機能します。このモデルは、ユーザーがAIの情報を過信しないようにするための仕組みを提供します。

3. 方法論

本研究では、Llama、Mistral、Gemmaの3つのバックボーンLLMを使用し、MultiWOZおよびSnipsの2つのタスク指向データセットで実験を行いました。アカウンタビリティヘッドを組み込むことで、AIエージェントが自身のエラーを信頼性高く推定し、より正確なアクションを生成することを目指しました。

4. 実験結果

実験の結果、MultiWOZデータセットにおいてアカウンタビリティヘッドを導入することで、ジョイントゴール精度が約3%向上しました。さらに、この手法によりエージェントが自身の行動を修正する能力も向上し、さらに3%のパフォーマンス向上を実現しました。これらの結果は、提案されたアカウンタビリティモデリングがユーザーの過剰依存を防ぐために有効であることを示唆しています。

5. 結論

本研究は、タスク指向会話AIにおけるユーザーの過剰依存を防ぐための新たなアプローチを提示しています。アカウンタビリティモデルの導入により、AIエージェントの信頼性が向上し、ユーザーがより正確な情報に基づいて意思決定を行えるようになることが期待されています。