目次

InfiFusion: A Unified Framework for Enhanced Cross-Model Reasoning via LLM Fusion

この論文は、複数の専門モデルを統合してクロスモデル推論を強化するための統一フレームワーク「InfiFusion」を提案し、特に新しい融合技術を通じてその性能を向上させる方法を探求しています。

この論文は、複数のドメイン特化型大規模言語モデルを効率的に統合するための新しいレート偏り適応フュージョン技術を提案し、推論精度を大幅に向上させる革新的なアプローチを示しています。

論文:https://arxiv.org/abs/2501.02795

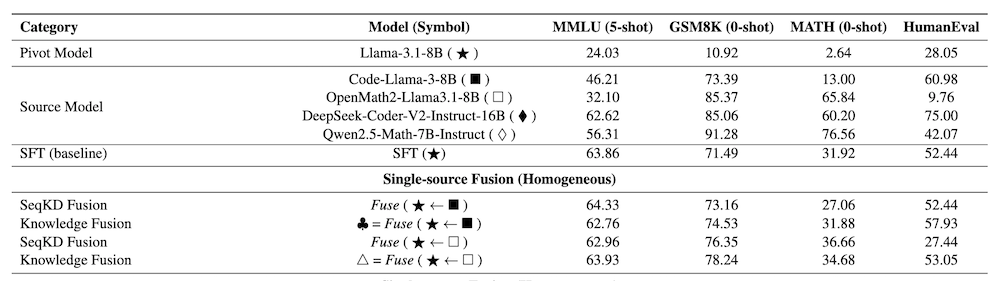

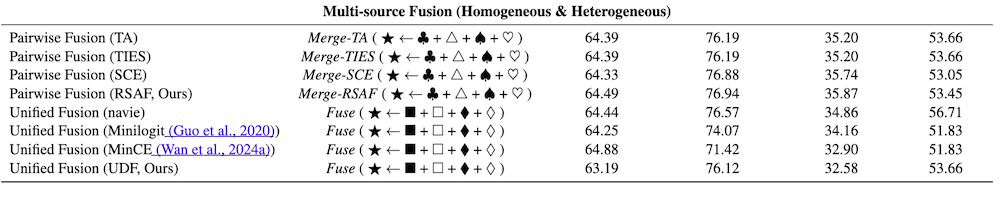

表は、一般的な推論(MMLU)、数学的推論(GSM8K, MATH)、およびコード生成(HumanEval)における性能比較です。♠ = Fuse(⋆ ← ■)は、ピボットモデル⋆(Llama-3.1-8B)にソースモデル■(Code-Llama-3-8B)の知識蒸留を実行することを示し、統合されたモデル(ピボットモデルLlama-3.1-8Bと同じアーキテクチャ)を♠で表します。Merge-TA(⋆ ← ♠ + △)は、TA手法を用いてピボットモデル⋆(Llama-3.1-8B)にソースモデル♠と△の重み統合操作を実行することを示します。

以下は、LLMを用いてこの論文の内容を要約したものになります。

概要

大規模言語モデル(LLM)は、さまざまな推論タスクにおいて強力なパフォーマンスを示していますが、すべてのドメインで一貫して優れたモデルを構築することは依然として困難です。本論文では、複数のドメイン特化型モデルを効率的に統合する戦略を探ることでこの問題に取り組みます。具体的には、複数のLLMの強みを組み合わせるための2つのフュージョン戦略を提案します。

1つ目は、ペアワイズ・マルチステップ・フュージョンアプローチで、各ソースモデルを順次ピボットモデルに蒸留し、その後、蒸留されたモデルを最終モデルに統合するための重み結合ステップを行います。この方法は強力なパフォーマンスを達成しますが、かなりのトレーニング労力を必要とします。

2つ目は、すべてのソースモデルの出力を集約する統一的なフュージョンアプローチです。このフュージョンプロセスを改善するために、パラメータ結合時にトップK比率を動的に調整する新しいレート偏り適応フュージョン(RSAF)技術を導入します。また、統一アプローチのために、不確実性に基づく重み付け手法を提案し、ソースモデルの寄与を動的にバランスさせ、他のロジット/分布アンサンブルよりも優れた性能を発揮します。この手法は、GSM8K、MATH、HumanEvalタスクにおいてそれぞれ9.27%、8.80%、8.89%の精度向上を達成しました。

InfiFusion: LLM融合による強化されたクロスモデル推論のための統一フレームワーク

1. 概要

本論文では、大規模言語モデル(LLM)が異なる推論タスクで強力な性能を示す一方で、全てのドメインで一貫して優れたパフォーマンスを発揮する単一モデルの構築が依然として困難であることを指摘しています。この課題に取り組むため、複数のドメイン特化型モデルを効率的に統合する戦略を提案しています。

2. 提案手法

本研究では、複数のLLMの強みを活かすために2つの主要な融合戦略を提案しています。

2.1 ペアワイズ・マルチステップ融合アプローチ

このアプローチでは、各ソースモデルを順次ピボットモデルに蒸留し、その後に重みを統合することで最終モデルを形成します。この手法は高い性能を発揮しますが、トレーニングにはかなりの労力を要します。

2.2 統一融合アプローチ

全てのソースモデルの出力を集約し、融合プロセスを改善するために、レート・スキュー適応融合(RSAF)技術を導入しています。この技術は、パラメータの統合時にトップKの比率を動的に調整し、柔軟性を向上させることを目的としています。

3. 不確実性に基づく重み付け

統一アプローチにおいて、不確実性に基づく重み付け手法を提案し、ソースモデルの寄与を動的にバランスさせます。この手法は、他のロジットや分布のアンサンブル手法を上回るパフォーマンスを達成することが示されています。

4. 実験結果

提案手法は、GSM8K、MATH、HumanEvalの各タスクにおいて、それぞれ9.27%、8.80%、8.89%の精度向上を実現しました。これにより、提案した統合フレームワークの有効性が確認されました。

本論文は、異なるスキルセットを持つ複数のモデルを効果的に融合させる新たな手法を提示しており、クロスモデル推論の領域において重要な貢献を果たしています。