目次

Inst-IT: Boosting Multimodal Instance Understanding via Explicit Visual Prompt Instruction Tuning

この論文は、明示的な視覚プロンプトを用いた指示調整を通じてマルチモーダルインスタンス理解を向上させるInst-ITという手法を提案しています。

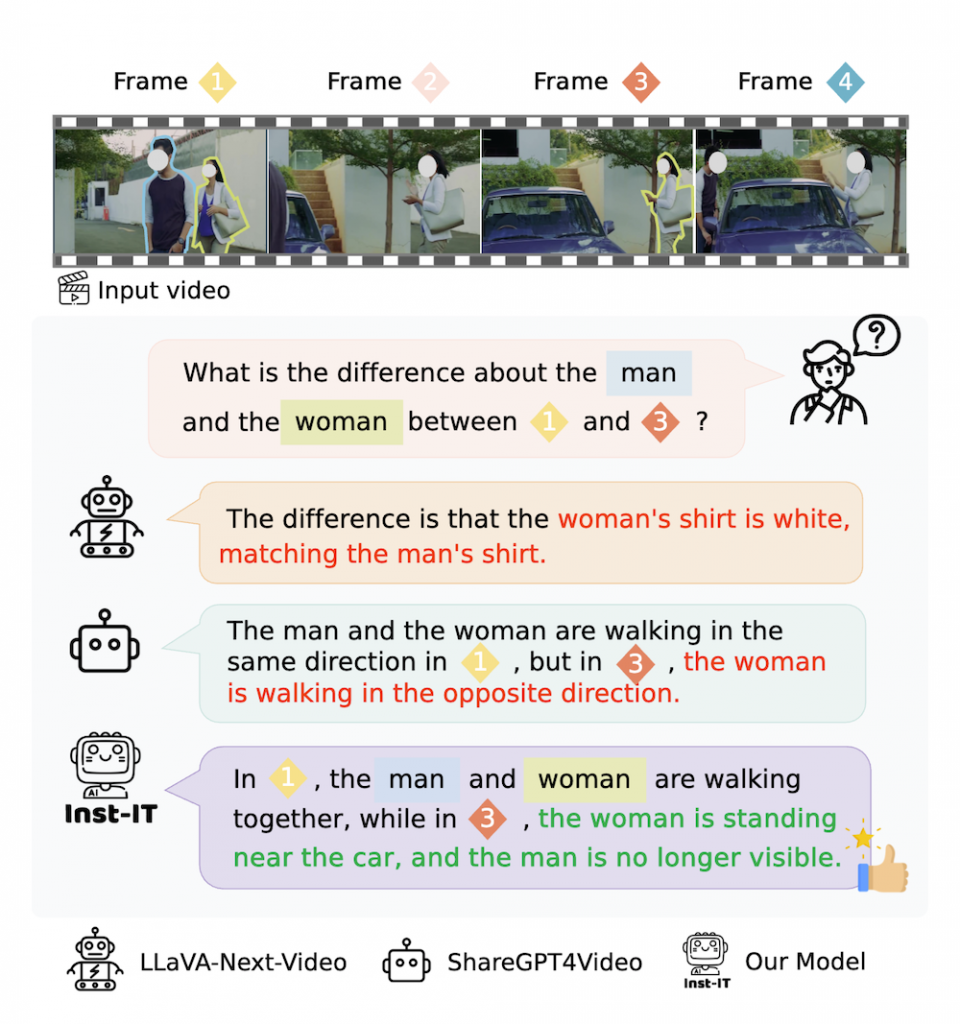

Inst-ITは、明示的な視覚プロンプトを利用して大規模マルチモーダルモデルのインスタンスレベルの理解を強化し、従来のモデルよりも優れた画像と動画の解析能力を実現するための新しいアプローチを提供します。

論文:https://arxiv.org/abs/2412.03565

リポジトリ:https://inst-it.github.io/

以下は、LLMを用いてこの論文の内容を要約したものになります。

概要

大規模マルチモーダルモデル(LMM)は、指示調整の進展により重要な突破口を迎えました。しかし、既存のモデルは画像や動画を全体的に理解することができる一方で、より微妙な理解と整合性が求められるインスタンスレベルの理解には苦労しています。インスタンスレベルの理解は、私たちが最も関心を持つ特定の要素に焦点を当てるため、重要です。興味深いことに、既存の研究は最先端のLMMが明示的な視覚的手がかりを与えられた場合に強力なインスタンス理解能力を示すことを発見しています。

これに触発され、私たちはGPT-4oを活用した自動注釈パイプラインを導入し、インスタンスガイダンスのための明示的な視覚プロンプトを通じて画像や動画からインスタンスレベルの情報を抽出します。このパイプラインに基づき、私たちはInst-ITを提案し、明示的な視覚プロンプト指示調整を通じてLMMのインスタンス理解を向上させるソリューションを提供します。Inst-ITは、マルチモーダルインスタンスレベルの理解を診断するベンチマーク、規模の大きな指示調整データセット、既存のLMMの空間的および時間的インスタンス理解能力を効果的に高めるための継続的な指示調整トレーニングパラダイムで構成されています。

実験結果は、Inst-ITの強化により、私たちのモデルがInst-ITベンチでの優れたパフォーマンスを達成するだけでなく、さまざまな一般的な画像および動画理解ベンチマーク全体で大幅な改善を示すことを示しています。これは、私たちのデータセットがインスタンスレベルの理解を向上させるだけでなく、一般的な画像および動画の理解能力全体を強化することを強調しています。

Inst-ITによるマルチモーダルインスタンス理解の強化

1. はじめに

1.1 背景

近年、マルチモーダルモデル(LMM)は画像や動画を全体的に理解する能力を持つ一方で、特定のインスタンスを理解する際には困難を抱えています。本研究では、これらの課題を解決するために、明示的な視覚的プロンプトを用いたインスタンス理解を強化するフレームワーク「Inst-IT」を提案します。

2. 提案手法

2.1 自動アノテーションパイプライン

Inst-ITは、GPT-4oを活用した自動アノテーションパイプラインを採用しています。このパイプラインは、画像や動画からインスタンスレベルの情報を抽出し、明示的な視覚的プロンプトを通じてインスタンスガイダンスを提供します。

2.2 Inst-ITの構成要素

Inst-ITは以下の要素から構成されています:

- ベンチマーク:マルチモーダルインスタンス理解を診断するための基準。

- 大規模な指示調整データセット:インスタンス理解を向上させるために設計されたデータセット。

- 継続的な指示調整トレーニングパラダイム:既存のLMMの空間的および時間的インスタンス理解能力を効果的に強化する手法。

3. 実験と結果

3.1 実験設定

研究の効果を評価するため、Inst-ITを用いてLMMのパフォーマンスを、Inst-ITベンチマークおよび一般的な画像・動画理解ベンチマークで比較しました。

3.2 結果

実験結果は、Inst-ITの導入によってモデルがInst-ITベンチマークで優れたパフォーマンスを達成し、さらに一般的な画像および動画理解ベンチマークでも顕著な改善が見られることを示しています。このことは、Inst-ITがインスタンスレベルの理解を高めるだけでなく、全体的な画像や動画理解能力も強化することを示唆しています。

4. 結論

Inst-ITは、明示的な視覚的プロンプトを用いてLMMのインスタンス理解能力を向上させる新たなアプローチを提供します。この手法は、既存のマルチモーダルモデルの限界を克服し、より高精度なインスタンスレベルの理解を実現可能にするものです。今後の研究では、さらなる改善と適用範囲の拡大が期待されます。

付録

本論文には、実験に使用したデータセットの詳細や評価基準に関する情報が含まれており、読者が実験の再現性を確保できるようになっています。