目次

DRS: Deep Question Reformulation With Structured Output

この論文は、未回答の質問を再構成するための新しいゼロショット手法「DRS」を提案し、大規模言語モデルの能力を向上させることを目的としています。

DRS手法は、エンティティの組み合わせをDFSアルゴリズムで反復的に探索し、構造化された出力を生成することで、質問の再構成精度を大幅に向上させる点が特に革新的です。

論文:https://arxiv.org/abs/2411.17993

リポジトリ:https://github.com/Lizhecheng02/DRS

以下は、LLMを用いてこの論文の内容を要約したものになります。

概要

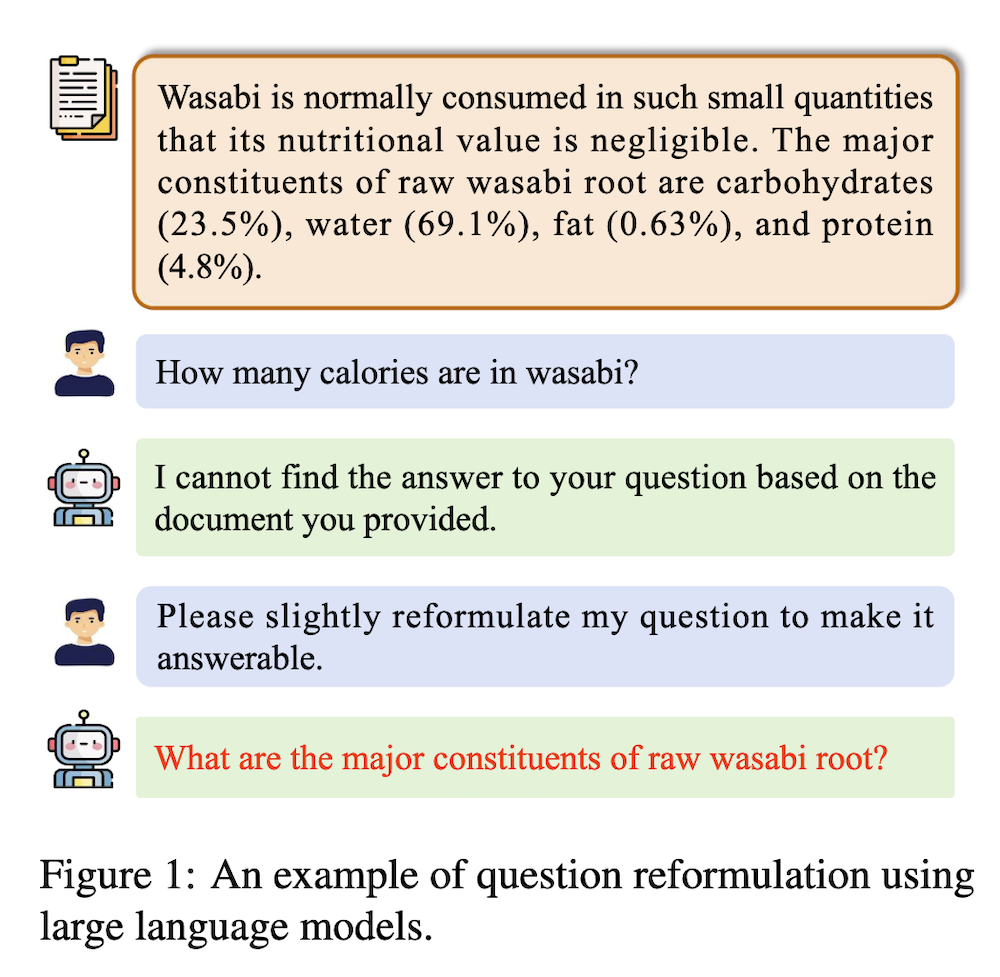

質問応答は大規模言語モデル(LLM)の基本的な能力です。しかし、人々が全く新しい知識テキストに直面するとき、彼らはしばしばテキストが理解できないために答えられない質問をします。最近の研究では、大規模言語モデルが質問の答えられないことを識別する能力はあるものの、質問を再構成する助けを提供する能力が不足していることが示されています。GPT-3.5のような強力なモデルでも、この点でのパフォーマンスは乏しいです。

LLMが人間に対して質問を再構成する能力を向上させるために、私たちは「DRS:構造化出力を伴う深い質問再構成」と呼ばれるゼロショット手法を提案します。私たちの提案する手法は、大規模言語モデルとDFSベースのアルゴリズムを活用して、可能なエンティティの組み合わせを反復的に検索し、特定のエンティティで出力を制約することで、この領域における大規模言語モデルの能力を効果的に向上させます。

広範な実験結果は、私たちのゼロショットDRS手法がGPT-3.5の再構成精度を23.03%から70.42%に大幅に改善し、GEMMA 2-9Bなどのオープンソースの大規模言語モデルのスコアを26.35%から56.75%に効果的に向上させることを示しています。

以下は、提供された情報をもとにした論文の解説です。各章ごとに内容をまとめ、明確に説明します。

1. DRS: 構造化出力による深層質問再構成

1.1 概要

本論文では、DRS(Deep Question Reformulation with Structured Output)という新しいゼロショット手法を提案し、大規模言語モデル(LLM)が新しい知識テキストから関連情報を抽出し、未回答の質問を効果的に再構成する能力を向上させることを目指しています。実験により、GPT-3.5の再構成精度は23.03%から70.42%に向上し、他のオープンソースモデルにおいても同様の改善が見られました。

1.2 はじめに

質問応答はLLMの基本的な能力ですが、特定のドメインの新しいテキストに対しては、ユーザーが答えられない質問を投げかけることが多いです。この現象は「前提条件エラー」と呼ばれ、実際のシナリオでは30%以上の質問が未回答となっています。本研究は、こうした未回答の質問を再構成する能力を向上させることに焦点を当てています。

1.3 貢献

本研究の主な貢献は、DRS手法を提案し、LLMが未回答の質問を効果的に再構成できるようにした点です。具体的には、GPT-3.5やオープンソースのLLMであるGEMMA 2-9Bの再構成精度を大幅に改善しました。

2. 関連研究

質問応答は自然言語処理の中心的な研究領域であり、多くのデータセットが開発されていますが、未回答の質問に対する再構成の研究はあまり進んでいません。最近の研究では、LLMが未回答の質問に対処するための方法が提案されていますが、再構成に特化したアプローチは限られています。

3. 方法論

DRS手法は、以下の三つの主要なステップで構成されています。

3.1 エンティティ抽出とフィルタリング

元の質問から重要なエンティティを抽出し、主語、目的語、属性などのカテゴリに分類します。これにより、再構成された質問が重要な情報に基づくようにします。

3.2 DFS組み合わせ探索と構造化質問生成

抽出したエンティティを使用して、深さ優先探索(DFS)アルゴリズムでエンティティの組み合わせを探索し、新しい質問を生成します。

3.3 候補質問の評価

生成された質問の中から最も信頼性の高い質問を選択するために、エンティティの重複数を基にした評価を行います。

4. 実験

4.1 データセット

本研究では、Zhao et al.(2024)によって構築されたCouldAskデータセットを使用し、1700以上の未回答の質問をテストデータとして使用しました。

4.2 大規模言語モデル

実験には、GPT-3.5、GPT-4 O-MINI、GEMMA 2-9B、QWEN 2.5-7Bの4つのモデルを使用しました。

4.3 評価指標

再構成の成功率を測定するために、回答可能性とエンティティの重複数を基にした精度を評価しました。

5. GPT評価器

評価モデルとしてGPT-4 O-MINIを採用し、LLAMA 2-7Bモデルよりも高い評価の精度とコスト効率を実現しました。

6. 実験結果

DRS手法は全てのデータセット及びモデルにおいて優れた性能を示し、特にGPT-3.5では平均精度が23%から70%に向上しました。

7. ケーススタディ

具体的な質問と再構成された質問の例を示して、DRS手法の有効性を強調しました。

8. 結論

本研究では、DRS手法が未回答の質問の再構成能力を大幅に向上させることを示しました。今後は、さらなる効果的な手法の開発を目指します。

附録

- A. 実装の詳細: 使用したモデルや実験の設定についての詳細が記載されています。

- B. 追加実験: 他の大規模言語モデルに対するDRS手法の一般性を検証するための追加実験結果が含まれています。

- C. DRSプロンプト: エンティティ抽出、分類、質問生成のための具体的なプロンプトが示されています。

この論文は、DRS手法の革新とその実用性を明確に示しており、今後の研究における重要な基盤を提供しています。