目次

Prompt Compression for Large Language Models: A Survey

この論文は、大規模言語モデルの効率を向上させるためのプロンプト圧縮技術を体系的に調査し、ハードプロンプトとソフトプロンプトの手法を比較・分析したサーベイです。

論文:https://arxiv.org/abs/2410.12388

リポジトリ:https://github.com/ZongqianLi/Prompt-Compression-Survey

以下は、LLMを用いてこの論文の内容を要約したものになります。

要約

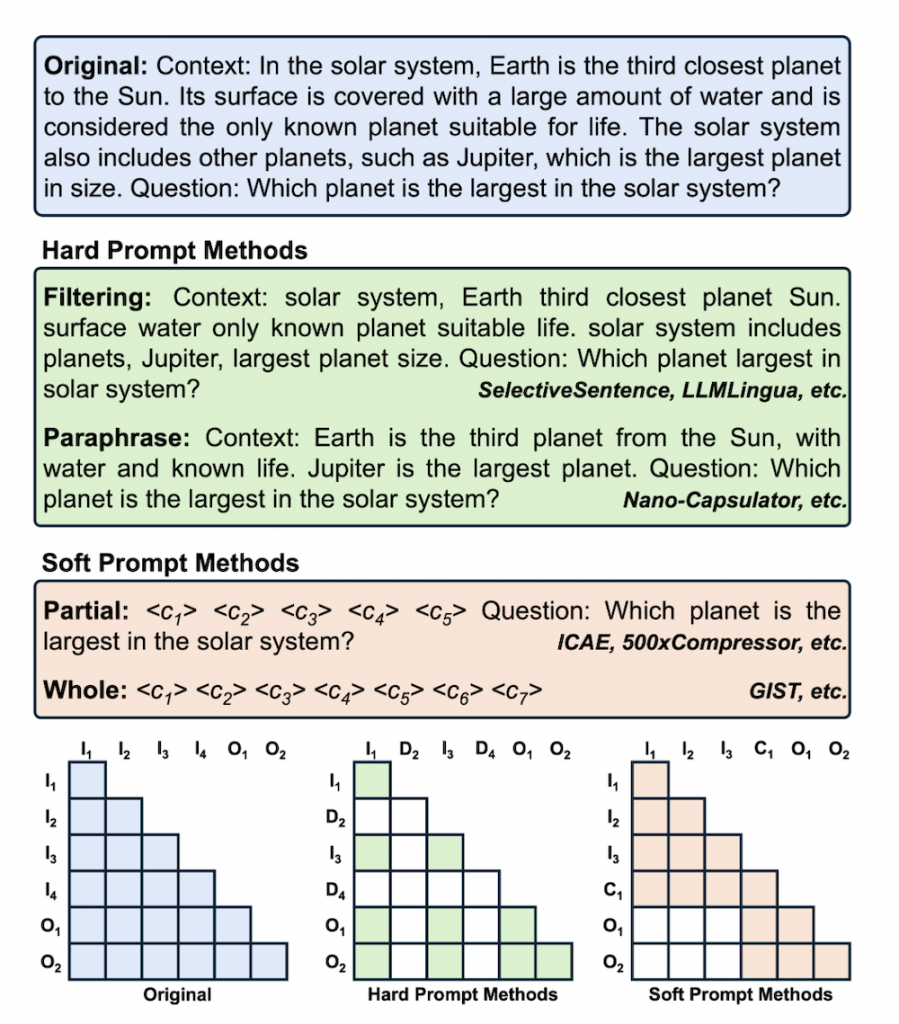

この論文では、大規模言語モデル(LLM)の効率を向上させるためのプロンプト圧縮技術について調査しています。プロンプト圧縮は、ハードプロンプトとソフトプロンプトの2つの方法に分類され、前者は低情報トークンの削除や言い換えにより簡潔さを追求し、後者はトークンの連続表現を学習することで情報を圧縮します。また、注意最適化やパラメータ効率的ファインチューニング(PEFT)などの視点からこれらのメカニズムを理解し、さまざまなプロンプト圧縮技術の適応を検討します。最後に、現在のプロンプト圧縮方法の限界と将来の研究方向についても提案しています。

この論文の特徴は、ハードプロンプトとソフトプロンプトの両方の圧縮技術を詳細に比較し、それぞれのメカニズムや適用可能性を探求することで、効率的な入力処理の新たなアプローチを提示している点です。

以下は、提供された情報を基にした論文の概要です。

プロンプト圧縮のための大規模言語モデル

1. はじめに

自然言語処理タスクにおいて、大規模言語モデル(LLM)の使用が増加しています。これに伴い、詳細な情報を伝えるために長文プロンプトが必要となり、推論速度の低下やメモリコストの増加を引き起こします。本論文では、プロンプト圧縮技術の必要性とそのアプローチを探求します。

2. 基礎知識

プロンプトは、タスクの指示として機能し、ハードプロンプト(自然言語トークン)とソフトプロンプト(訓練可能な連続ベクトル)に分類されます。プロンプト圧縮の目的は、プロンプトの長さを短縮し、LLMの処理効率を向上させることです。

2.1 プロンプトの種類

- ハードプロンプト: 人間またはモデルによって生成され、簡潔な指示を提供しますが、あいまいさが生じることがあります。

- ソフトプロンプト: より微妙な意味を伝えることができる一方で、説明性が低くなります。

3. ハードプロンプト手法

ハードプロンプト手法は、自然言語のトークンを利用しながら冗長な部分を削除します。主な手法には以下があります。

3.1 SelectiveContext

自己情報量を使用して冗長な部分を特定し削除しますが、再エンコードが必要です。

3.2 LLMLingua

小型の言語モデルを用いて困惑度を計算し、冗長なトークンを削除します。最大20倍の圧縮を達成しますが、外部メモリが必要です。

3.3 Nano-Capsulator

元のプロンプトを要約し、重要な意味を保持するためのセマンティック保持損失を導入します。

4. ソフトプロンプト手法

ソフトプロンプト手法では、プロンプトを短い連続トークンの列に圧縮します。代表的な技術には以下があります。

4.1 Contrastive Conditioning (CC)

自然言語プロンプトの出力分布を近似する短いソフトプロンプトを訓練します。

4.2 GIST

注意メカニズムを改良し、圧縮トークンが元のプロンプトに注意を向けることを可能にします。

4.3 AutoCompressor

長いプロンプトを複数のサブプロンプトに分け、再帰的に圧縮します。

5. 下流適応

プロンプト圧縮は、一般的なQA、RAG、ICL、エージェントシステムなどに広く適用され、特にxRAGやUniICLなどが注目されています。

6. 課題と今後の研究

現在のプロンプト圧縮手法は、情報損失やモデル能力の低下などの課題に直面しています。今後は、エンコーダの最適化やハード・ソフトプロンプトの組み合わせが提案されています。

7. 結論

本論文は、ハードおよびソフトプロンプト手法の観点からプロンプト圧縮技術を包括的に概説し、その技術的アプローチや将来の研究方向を提案しています。

付録

付録では、プロンプト圧縮法に関する参考文献や手法の概要、アーキテクチャの比較図が含まれています。