目次

GSM-Symbolic: Understanding the Limitations of Mathematical Reasoning in Large Language Models

この論文は、大規模言語モデルの数学的推論能力の限界を探り、GSM-Symbolicという新しいベンチマークを通じてその脆弱性を明らかにしたものです。

論文:https://arxiv.org/abs/2410.05229

以下は、LLMを用いてこの論文の内容を要約したものになります。

要約

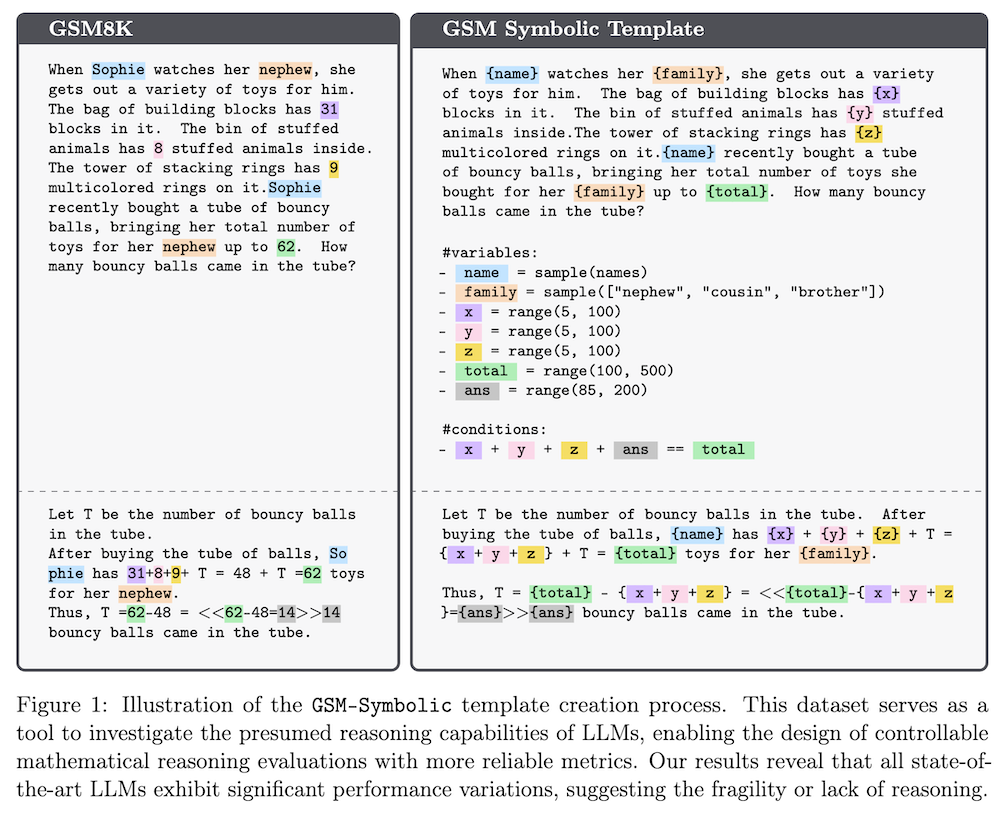

この論文では、大規模言語モデル(LLMs)の数学的推論能力の限界について探究しています。GSM8Kベンチマークを用いて、LLMsの性能向上が本当に推論能力の進展を反映しているのか疑問を呈し、新たにGSM-Symbolicというベンチマークを提案しています。この新しいベンチマークは、多様な質問を生成できるシンボリックテンプレートから作成され、LLMsの評価をより制御可能にします。結果として、モデルは質問の数値を変更するだけで性能が大きく低下し、複雑な状況では推論能力が脆弱であることが示されました。最終的に、LLMsは真の論理的推論を行う能力が不足しており、パターンマッチングに依存していることが明らかになりました。

この論文の特徴は、新たに提案されたGSM-Symbolicベンチマークが、従来のGSM8Kよりも多様な質問を生成し、LLMsの数学的推論能力をより詳細かつ制御可能に評価できる点にあります。

1. はじめに

1.1 背景

大型言語モデル(LLMs)は、自然言語処理や質問応答の分野で顕著な能力を示していますが、特に数学的推論能力についてはその真の実力が疑問視されています。GSM8Kベンチマークは学年レベルの数学問題を評価するために広く使われていますが、従来の評価方法には限界があるため、より信頼性のある評価基準が求められています。

1.2 目的

本研究は、GSM-Symbolicという新たなベンチマークを導入し、LLMsの数学的推論能力をより詳細に評価することを目的としています。この新しいベンチマークは、符号化されたテンプレートに基づいて多様な質問を生成し、モデルの推論能力をより正確に測定することを可能にします。

2. 関連研究: 推論と言語モデル

2.1 推論の重要性

LLMsの推論能力は不安定であり、これまでの研究では、モデルがどのようにタスクを解決するかを調査してきました。トランスフォーマーアーキテクチャの限界が指摘されており、論理的推論を行う能力には多くの課題があります。

2.2 これまでの研究

近年の研究により、LLMsが形式的な推論を行うことは難しく、主にパターンマッチングに依存していることが示されています。これにより、トークンの変更が出力に大きな影響を与えることが確認されています。

3. GSM-Symbolic

3.1 GSM-Symbolic: テンプレート生成

GSM-Symbolicでは、GSM8Kデータセットを基に、多様な質問を生成するためのテンプレートを作成します。このプロセスでは、質問の変数、条件、ドメインを特定し、生成されたデータの正当性を自動的に検証する仕組みが導入されています。

3.2 実験設定

本研究では、20以上のLLMsを対象に、各モデルから生成された5000の例を用いて評価を行いました。Chain-of-Thought(CoT)プロンプトを使用し、8ショット設定でモデルのパフォーマンスを測定しました。

4. 実験と結果

4.1 GSM8K結果の信頼性

GSM-Symbolicにおけるモデルのパフォーマンスには顕著なばらつきがあり、GSM8Kの結果はデータ汚染の可能性を示唆しています。

4.2 数字の変更に対する脆弱性

モデルの性能は、名前の変更よりも数値の変更に対して敏感であり、特に数値が変更されるとパフォーマンスが大きく低下することが分かりました。これは、LLMsが形式的な推論を行わず、パターンマッチングを行っていることを示しています。

4.3 質問の難易度の影響

質問の難易度が上がると、モデルの平均性能が低下し、パフォーマンスのばらつきが増加することが観察されました。特に、質問内の節が増えると性能が一貫して低下しました。

4.4 数学的概念の理解

GSM-NoOpデータセットを用いた実験では、無関係な情報が追加された場合にモデルのパフォーマンスが65%低下することが確認され、これはモデルが数学的概念を適切に理解していないことを示唆しています。

5. 結論

本研究を通じて、LLMsの数学的推論能力と現在の評価方法の限界を明らかにしました。GSM-Symbolicを導入することで、モデルのパフォーマンスの変動性を示し、LLMsが真の数学的推論を行う能力には限界があることが分かりました。今後の研究では、より堅牢で一般化可能な問題解決能力を持つAIモデルの開発が重要な課題であると考えられます。

付録

A.1 詳細な実験設定

本研究の全ての評価結果は、Chain-of-Thoughtプロンプトを使用した8ショット評価に基づいています。

A.2 完全な結果

GSM8Kおよびその異なるバリエーションに対する各モデルのパフォーマンス結果を示しています。

A.3 パフォーマンス分布の追加結果

GSM-Symbolicにおけるパフォーマンスの分布の追加結果を提供します。

A.4 難しいタスクに対するファインチューニング

ファインチューニングが難しいタスクにおけるパフォーマンス改善に関する結果を示します。

A.5 新モデルの結果

新たにリリースされたo1-previewおよびo1-miniモデルのパフォーマンスを示し、これらのモデルにも限界があることを指摘します。

この解説記事は、LLMsにおける数学的推論能力の現状と課題を明らかにし、今後の研究の方向性を示すものです。