目次

GDI-Bench: A Benchmark for General Document Intelligence with Vision and Reasoning Decoupling

この論文は、視覚と推論の複雑さを分離した一般的な文書知能のベンチマーク「GDI-Bench」を提案し、文書特有のタスクにおけるモデルの能力を評価するための新しい基準を提供しています。

GDI-Benchは、視覚的複雑性と推論の複雑性を分離したタスク構造を持ち、モデルの性能を難易度別に評価することで、特定の弱点を明確にし、最適化の指針を提供する点が特徴です。

論文:https://arxiv.org/abs/2505.00063

以下は、弊社AI開発ツール「IXV」を用いてこの論文を要約したものです。見出しや章立てが元論文とは異なる場合があります。

概要

この論文では、マルチモーダル大規模言語モデル(MLLM)の急速な進展が文書領域に与える影響と、それに伴うさまざまなアプリケーションシナリオを強調しています。この進展は、これらのモデルの能力を評価するための包括的なベンチマークの必要性を浮き彫りにしています。しかし、既存のベンチマークは特定のモデルの弱点を特定したり、体系的な改善を促すことができていません。

このギャップを埋めるために、私たちは一般文書知能ベンチマーク(GDI-Bench)を導入します。これは、9つの主要なシナリオと19の文書特有のタスクにわたる1.9千枚の画像を特徴としており、視覚的複雑性と推論の複雑性を分離することにより、難易度別のタスクを構造化しています。これにより、パフォーマンスの評価が可能となり、モデルの弱点特定や最適化の指針となります。

私たちは、オープンソースおよびクローズドソースのさまざまなモデルでGDI-Benchを評価し、視覚および推論領域での分離分析を実施しました。例えば、GPT-4oモデルは推論タスクにおいて優れている一方で、視覚能力には限界があることが分かりました。GDI-Benchにおける多様なタスクとドメインに対処するために、私たちは知能保存型のトレーニング戦略を通じて、監視付きファインチューニング(SFT)プロセス中の壊滅的忘却の問題を軽減するGDIモデルを提案します。このモデルは、以前のベンチマークとGDI-Benchで最先端のパフォーマンスを達成しました。私たちのベンチマークとモデルは、どちらもオープンソースとして提供されます。

1. はじめに

大規模言語モデル(LLM)の急速な進歩により、マルチモーダル大規模言語モデル(MLLM)が人工知能の基盤となり、文書インテリジェンスを一般的な段階へと進化させました。クロスドメインでマルチスケールの文書理解と抽出の課題は、実世界のアプリケーションでますます重要になっています。MLLMの登場に伴い、より複雑なベンチマークが出現しましたが、文書理解は複数のモダリティを含むため、MLLMの出力エラーは不正確な視覚認識、限られた言語構成、あるいはその両方から生じる可能性があります。そのため、MLLMの文書処理能力の分離評価が不可欠です。

2. 関連研究

2.1 文書ベンチマーク

初期の文書理解ベンチマークは主に単一ドメインのデータと特定のタスクを対象としていました。DocVQA、VisualMRC、ChartQAなどがその例です。これらのベンチマークは貢献がありましたが、当時のモデルの限られた一般化能力により、難易度の階層化やクロスドメインの一般化が欠けていました。マルチモーダル大規模モデルの台頭により、OCRBenchV2、Fox、OmniDocBenchなどのより複雑なベンチマークが登場しましたが、これらのベンチマークは評価の範囲を広げたものの、明示的な難易度の評価が欠けており、様々な複雑さのタスクでのモデルパフォーマンスを評価する能力が制限されています。

2.2 文書理解モデル

光学文字認識(OCR)はコンピュータビジョンの基本的なタスクとして長く存在してきました。既存のOCRモデルはコンポーネントベースとエンドツーエンドのアプローチに大きく分類できます。コンポーネントベースの方法はレイアウト分析、テキスト検出、領域抽出、コンテンツ認識などの複数の専門設計コンポーネントを組み立てるモジュラーパイプラインを採用しています。一方、エンドツーエンドOCRモデル、特に大規模ビジョン言語モデル(LVLM)によって駆動されるものは、単一のアーキテクチャ内で認識と推論を統一することを目指しています。LVLM-ベースのOCRシステムのほとんどは、視覚バックボーンとしてCLIPを利用し、統一されたフレームワークで視覚的および文字情報を共同で処理するために言語モデルと結合しています。

2.3 LLMの継続学習

大規模言語モデル(LLM)の継続学習では、破滅的忘却が重要な課題です。既存の研究は主にデータリプレイとパラメータ凍結の2つの戦略を採用しています。データリプレイ戦略は、新しいタスクのトレーニング中に以前のタスクからのサンプルを再訪することで忘却を軽減します。LAMOLなどの典型的なアプローチは、ストレージベースのリプレイを避けるために言語モデルを使用して疑似サンプルを生成します。一方、パラメータ凍結法は、LoRA、アダプター、プロンプトトークンなどの軽量モジュールの微調整を通じてパラメータ更新を制限することで、既存の知識を保護します。また、弾性重み統合(EWC)などの古典的な正則化ベースの手法は、重要性の制約を通じて重要な重みパラメータを保護します。

3. ベンチマーク

3.1 複雑性の分離

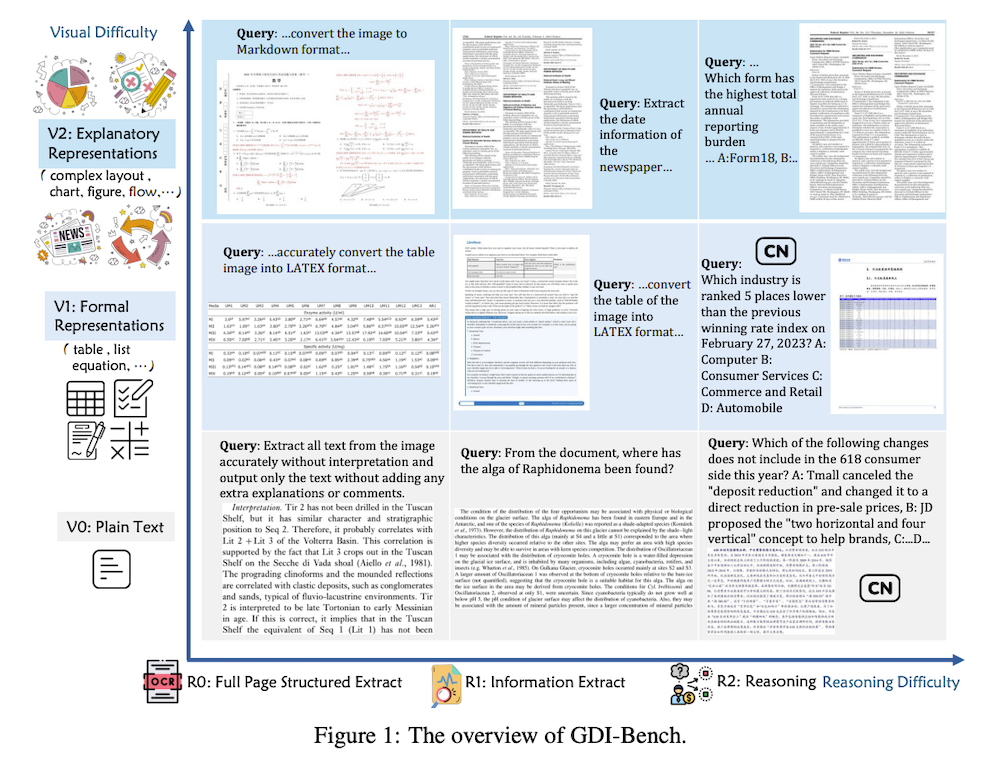

図1に示すように、MLLMの視覚情報理解と推論の能力を包括的に評価するために、難易度分離評価プロトコルであるGDI-Benchmarkが導入されています。VisualSimpleQAの事実探索質問応答タスクを視覚認識と知識次元に構造的に分解するのとは異なり、提案されるフレームワークは視覚的複雑性と推論複雑性の要素に分解することで、基本的な難易度の観点からタスクの複雑性を特徴付けています。

3.1.1 視覚的複雑性

視覚的複雑性の次元は、文書画像を3つのレベルに階層的に分類することで実現されています:V0(プレーンテキスト)、V1(形式的表現)、V2(説明的表現)。V0は見出しや段落などの非構造化テキスト要素のみを含んでいます。V0文書のマルチモーダルタスクは通常、OCR-LLMパイプラインアーキテクチャを通じて満足のいくパフォーマンスを達成します。図2に示すように、Omnidocbenchベンチマークの系統的分析により、統計的に有意なパフォーマンスのギャップが明らかになっています。

3.1.2 推論複雑性

推論複雑性の特徴付けは、行動駆動型の分類法を通じて定式化されています。文書理解能力を段階的に評価するために、3つの異なるレベルが定義されています。これは具体的にR0:完全ページ構造抽出、R1:情報抽出、R2:推論に分類されています。これらのうち、V0におけるR0タスクはOCRに似ており、V1およびV2タイプの画像における表、式、複雑なページ構造などのレイアウト情報を理解する能力が必要です。

3.2 アノテーションプロセス

3.2.1 データソース

一般文書インテリジェンス(GDI)ベンチマークのデータ取得フェーズでは、文書は主に9つのドメインからの文書画像を含む包括的なデータセットであるOmnidocbenchから調達されました。データセットはさらに、試験用紙、レポート、新聞などの様々な文書タイプを含む社内収集によって補完されました。

3.2.2 データ構築

図3に示すように、データ構築プロセスはOmnidocbenchと社内文書から単一レイアウトのサブイメージをクロップすることから始まり、V0生画像セットを形成します。Omnidocbenchでの最先端モデルおよびパイプラインツールからのエンドツーエンド編集距離スコアに基づいて、0.142以上のスコアを持つドメインはV2に分類され、高い視覚的複雑性を示しています。

3.3 評価指標

指標はタスクタイプごとに定義されています。R0は文字レベルの認識精度の平均編集距離(AED)を使用しています。R1はエンティティとフィールド抽出評価のために平均正規化レーベンシュタイン類似度(ANLS)を採用しています。R2では、ほとんどのタスクが単一選択の回答を必要とするため、精度が主要な指標です。

3.4 既存の文書インテリジェンスベンチマークとの比較

表2に示すように、既存の文書インテリジェンスベンチマークはシナリオカバレッジ、タスク多様性、またはデータスケールのいずれかで限定されています。対照的に、GDI-Benchは9つの多様な文書シナリオと19の代表的なタスクのバランスの取れた組み合わせを、1.9kの厳選された画像セットに基づいて提供しています。

4. 方法論

GDI-Benchはモデル設計に独自の課題を提示しており、タスク特化型のパフォーマンスを向上させるための教師付き微調整の適用を動機付けています。これに対処するために、我々はベンチマークと構造的に一致していながら、多様なデータドメインから引き出されたタスクを含むマルチソーストレーニングセットを開発しました。この訓練セットを使用してInternVL3-8Bモデルに対してSFTを実施しましたが、モデルの評価を通じて、モデルが事前学習中に獲得した必須知識を失う、著しい破滅的忘却が明らかになりました。

5. 実験

5.1 レイヤーワイズ適応的凍結調整

5.1.1 クロスドメインとクロスタスクの評価

LW-AFT方法のクロスドメインおよびクロスタスク環境での一般化能力を検証するために、以下の実験を設計しました。

クロスドメイン実験(同一タスク):

- T1:学術論文ドメインでの段落開始位置OCRタスクをトレーニングし、インフォグラフドメインで同じタスクをテスト

- T2:試験と学術論文ドメインでの情報フォーマッティングと組織化(JSON)タスクをトレーニングし、インフォグラフドメインでテスト

- T3:学術論文ドメインでの推論と質問応答タスクをトレーニングし、財務報告ドメインでテスト

クロスタスク実験(同一ドメイン):

- T4:新聞ドメインで、ヘッダー情報抽出とそのフォーマッティング組織化(JSON)タスクのみをトレーニングし、ヘッダー詳細情報(新聞の日付、編集者、メール、電話番号を含む)の抽出タスクをテスト

5.1.2 一般的なデータセットでのパフォーマンス

全パラメータ微調整、LoRA微調整、および我々の方法の一般的なデータセットに対するパフォーマンスを評価しました。表5に示すように、我々の方法はSFT後もモデルの一般的な能力を保持し、破滅的忘却を回避していることがわかります。

5.2 ベンチマーク評価結果

一般化されたOCRタスクに対する我々のGDIモデルの有効性を評価するために、GDI-Benchのマルチレベルチャレンジスイート(v0-r0からv2-r2まで)において、Qwen2.5-VL-72B、Gemini-2.0-Flash、GPT-4o-2024-11-20、Claude-3-5-Sonnet、およびGrok-2-Visionなどの最先端のビジョン言語モデルと比較しました。すべての評価は同じ前処理パイプラインで実施されました。

6. 結論

我々はGDI-Benchを紹介しました。これは広範なドメインカバレッジを持つ文書ドメインのベンチマークであり、体系的な難易度評価システムを先駆けて実現しています。複雑性分離メカニズムを利用して、GDI-Benchはマルチモーダル文書タスクを視覚的複雑性と推論複雑性という2つの直交する次元に分解しています。また、Layer-wise Adaptive Freeze-Tuning手法と対応するGDIモデルを提案しました。LW-AFTはSFT中の破滅的忘却の問題を軽減し、SFTプロセス中にモデルの一般的な能力の99%を保持し、クロスドメインとクロスタスクシナリオでのパフォーマンスを向上させます。