目次

JMMMU: A Japanese Massive Multi-discipline Multimodal Understanding Benchmark for Culture-aware Evaluation

この論文は、日本文化に基づいた専門的タスクに対する大規模なマルチモーダルモデルの評価基準である「JMMMU」を提案し、非英語におけるモデルの理解度と文化的理解の限界を明らかにすることを目的としています。

論文:https://arxiv.org/abs/2410.17250

リポジトリ:https://mmmu-japanese-benchmark.github.io/JMMMU/

以下は、LLMを用いてこの論文の内容を要約したものになります。

要約

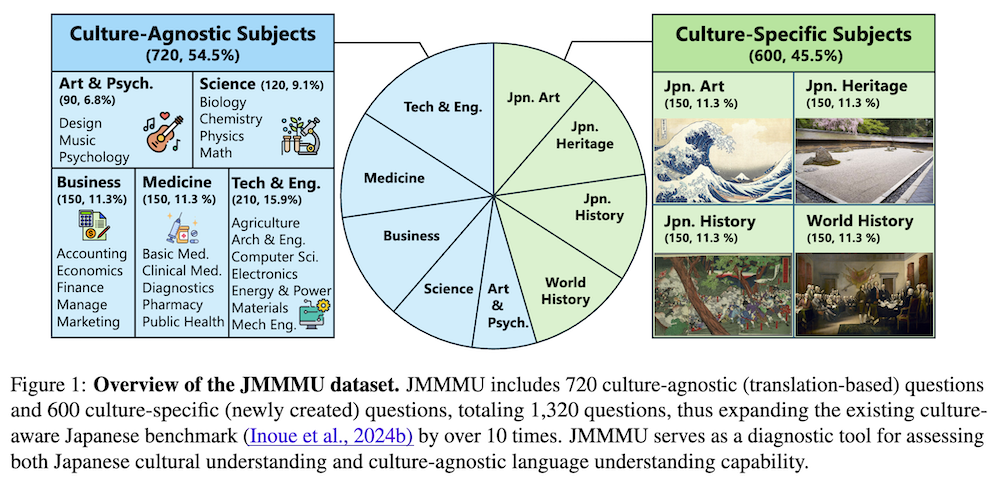

この論文では、非英語圏における大規模マルチモーダルモデル(LMM)の研究を加速させるために、日本文化に基づく専門的なタスクを評価するための初の大規模な日本語ベンチマーク「JMMMU」を紹介しています。JMMMUは、文化非依存の課題を含む「文化無関係(CA)」サブセットと、日本文化に特化した新たな課題を含む「文化特有(CS)」サブセットの2つの部分から構成されており、合計1,320問の質問で構成されています。研究結果として、ほとんどのLMMは日本語での評価において英語と比べてパフォーマンスが低下し、文化特有の理解が不足していることが明らかになりました。このベンチマークは、日本語におけるLMMの性能向上を目指し、文化的に多様な基準の作成を促進することを期待しています。最終的に、JMMMUは多文化に配慮したLMMの発展に寄与することを目指しています。

JMMMUは、文化的文脈を考慮した専門的なタスク評価を通じて、日本語における大規模マルチモーダルモデルのパフォーマンス向上を目指す、初の大規模ベンチマークである点が特筆すべき特徴です。

JMMMU: 日本文化に配慮した評価のための大規模多分野マルチモーダル理解ベンチマーク

1. はじめに

本論文では、日本語に特化した大規模マルチモーダルモデル(LMM)の性能を評価するための新しいベンチマーク「JMMMU」を紹介します。近年の研究は主に英語に焦点を当てているため、他の言語のモデル性能評価が不足している状況を踏まえ、JMMMUは日本文化に基づく専門的なタスクの評価を目指しています。

2. 背景

大規模言語モデル(LLMs)の進展により、自然言語処理の分野で革新が進んでいますが、LMMsに関しては、主に英語のベンチマークに依存しており、多様な言語に対する評価の必要性が高まっています。JMMMUは、専門的知識や文化的理解を評価するために設計された初の日本語ベンチマークです。

3. JMMMUベンチマークの概要

JMMMUは、合計1,320の質問と1,118の画像から成り、以下の2つのサブセットで構成されています。

- 文化に依存しないサブセット(CA): 英語のMMMUから翻訳された720の質問。

- 文化特有のサブセット(CS): 日本文化を反映した600の新しい質問。

この構成により、日本語におけるLMMの性能を多角的に評価することが可能になります。

4. データキュレーションプロセス

JMMMUは、元のMMMUから派生した900の質問ベースに、日本語に翻訳され、文化的文脈に適した問題を新たに作成するプロセスを経ています。この過程には19人の日本語ネイティブスピーカーが関与し、専門的な知識が求められました。

5. 実験設定

実験では、商業用およびオープンソースのLMMを評価しました。具体的には、GPT-4oやGemini 1.5 Proなどのプロプライエタリモデル、およびLLaVAやInternVLなどのオープンソースモデルが含まれています。

6. 主な結果

評価の結果、オープンソースモデルの最高スコアは40.5%、プロプライエタリモデルでは58.6%でした。特に、CAサブセットにおいては、日本語でのパフォーマンスが英語よりも低下する傾向が確認されました。

7. エラー分析

エラー分析では、以下の点に着目しました。

- 画像翻訳の影響: テキストと画像の翻訳がモデルのパフォーマンスに及ぼす影響を調査し、翻訳によるパフォーマンスの低下が見られるモデルが多かった。

- 文化に依存しないサブジェクトのエラー: 特に日本語でのみ正しい回答をするケースが多く、翻訳の影響が強いことが明らかになりました。

- 文化特有のサブジェクトのエラー: 知識の不足や画像認識エラーが主な原因として挙げられました。

8. 結論

JMMMUは、日本文化に基づく専門的な知識と推論能力を評価するための重要なベンチマークであり、今後の多言語評価の基準を提供します。この研究は、LMMの開発における文化的理解の重要性を示しており、今後の研究における指針となることが期待されます。

付録

- A. LMMの日本語サポート: 各モデルの日本語サポート状況をまとめた表。

- B. 結果の詳細: 各モデルのエラー分析や翻訳の影響についての詳細な結果。

- C. 実験設定: 実験で使用した計算インフラやパラメータ設定に関する詳細。

- D. 注釈指示: 参加者への指示文書を提供し、データの翻訳と評価手順を示す。

- E. サンプル問題: 文化に依存しないサブセットと文化特有のサブセットからのサンプル問題を提供。

このように、JMMMUは日本語に特化したLMMの評価を行うための新たな枠組みを提供し、多様な文化に対する理解を深める手助けとなることを目指しています。